Diskussion:Datenschwemme (BD2015)

ad: Chris Anderson:

Im Text von Chris Anderson wird erklärt, dass die schiere Menge der Daten einen anderen Zugang zur Datenverarbeitung verlangt, da in Bezug auf Big Data klar geworden ist, dass die Datenmengen nicht mehr zu einem umfassenden Ganzen zusammengefasst werden können, das in seiner Gänze überschaubar wäre. Eine Folgerung wird rasch vorgenommen: “It forces us to view data mathematically first and establish a context for it later.” Wenn man die Datenflut nicht überblicken kann, ist es also das Beste, einfach weiter Daten zu sammeln, denn irgendwann wird sich schon von selbst etwas daraus ergeben. Denn die Daten sprechen für sich selbst.

Der Ausgangsthese ist meiner Meinung nach zuzustimmen; die Datenmengen werden unüberschaubar. Allerdings wäre eine alternative Folgerung naheliegender: Je mehr Daten gesammelt werden, desto unüberschaubarer wird das Ganze. Und das betrifft die Input- ebenso wie die Prozess- und die Output-Phase.

Mit “Input” sind diejenigen gemeint, die die Daten generieren: Menschen und Artefakte, die in welcher Weise auch immer tätig sind. Je mehr Daten erhoben werden, desto schwieriger wird es für den Datenproduzenten zu überblicken, wie und auf welche Weise Daten gesammelt werden. Das macht die Regelung dieser Vorgänge schwierig. Je mehr Datenerhebung vorgenommen wird, desto komplizierter werden die Regelungen, die diese Erhebung betreffen und die garantieren, dass der einzelne Betroffene damit konform geht oder gut in den Erhebungsprozess eingebunden ist. Je mehr Datenerhebung, desto mehr “privacy agreements”. Nun ist, man nehme etwa Walter Lippmann und seine Argumentation in The Phantom Public; es nicht möglich, dass jeder zu jeder Zeit alles weiß. Es ist zu viel verlangt, wenn vorausgesetzt wird, dass sich User über die hinzuaddierten Übereinkünfte ausreichend im Klaren sind. Je mehr Faktoren daran beteiligt sind, desto unübersichtlicher und zeitintensiver wird es, einen Überblick zu behalten, welche Daten wie erhoben werden und was damit passiert. Dass in dem Text von Chris Anderson davon nicht die Rede war, erzeugt den Eindruck, als werde die Meinung vertreten, Daten seien einfach da. Dass dies nicht der Fall ist, weil Daten erst erzeugt werden müssen, ist der erste Hinweis, dass die Daten nicht für sich selbst sprechen; sie werden durch ihre Erzeuger formuliert. In welcher Weise diese Formgebung stattfindet ist eine Frage, die noch vor der Bearbeitung entschieden werden muss, oder die zumindest im Zuge des Bearbeitungsprozess immer wieder neu gestellt werden muss. -> Erster Einwand: Die Frage, was das für Daten sind und auf welche Weise sie erhoben werden, geht der mathematisch-statistischen Bearbeitung voraus. Je unüberschaubarer die Datenmengen, desto unüberschaubarer die Art der Regelungen, wie diese Daten erhoben werden. Der Kontext bedingt die Erhebung.

- "Daten erheben" ist ein bedenkenswerter Ausdruck. Daten sollen für sich selbst sprechen -- aber das macht nur Sinn, wenn sie vorher da sind. Wie steht das zur Datenerhebung? Ein naives Modell besagt, dass sie zuerst gefunden werden und dann "das Ihre" sagen. So wie man auf eine Metallteil stösst, das den Namen des Produzenten der Maschine trägt, von dem es stammt.

- Daten sind eben nicht einfach da. Sie werden "formuliert", das ist ein weiterer bedenkenswerter Ausdruck, allerdings nicht in der Umgangssprache. Aber er passt bestens zu den Formularen, die wir besprochen haben. Das ist eine Formgebung und zwar eine Bearbeitung vor der Bearbeitung, der Daten später unterworfen werden.

- Auch das ist ein naives Modell: Daten werden in Formularen erfasst, z.B. Name, Geburtsort und Adresse im Hotel. Aber die Name von Personen sind nicht "für sich selbst" Daten. Sie werden Daten, indem sie archivarisch und/oder datenbanktechnisch gefasst werden, erst dann können sie "erhoben" werden. Sie werden nicht "erfasst" und dann bearbeitet", sondern sie werden zu Daten, indem sie "formuliert" werden. --anna (Diskussion) 20:15, 2. Dez. 2015 (CET)

Mit “Prozess” ist die Verarbeitung der Daten gemeint. Im Text von Anderson wird darauf hingewiesen, dass Daten etwas tun; sie sprechen für sich selbst, woraus sich Aussagen über die Wirklichkeit der Welt ergeben. Ob Daten nun von Wissenschaftlern oder von “unbemannten” Computerprogrammen prozessiert werden, es handelt sich bei dem Prozess der Verarbeitung um eine Prozess der Übersetzung. Wenn Interessen und Vorlieben von Menschen oder zurückgelegte Wegstrecken, die vom Mobiltelefon erkannt werden, geschieht eine Übertragung einer Form oder gar eines Identitätskonstrukts; aus Literaturgeschmack und Muskelbewegungen werden mathematisch erfassbare Aussagen, diese werden zu elektrischen Impulsen, die über Kabelverbindungen um die Welt rasen, daraus wieder datenbankmäßig erfassbare Aussagen und daraus hierarchisch geordnete Suchergebnisse. Alle diese Erscheinungsformen haben nichts miteinander gemeinsam, außer den Weg, den sie zurücklegen, also die Spur der Übersetzungen, Bewertung, hierarchischer Einordnung, usw., die sie absolviert haben. Nun mag man der Meinung sein, dass sich Daten, eben weil es sich vermeintlich um mathematisch-statistische Aussagen handelt, ohne “Kosten” übersetzt werden können, aber diese Perspektive ist nicht überzeugend. Eine Rücküberetzung nach dem Transport bleibt immer noch eine Übersetzung; Reduktion ist kein Zurückgehen zum Ausgangspunkt, sondern nur eine weitere Art von Transport. Und die Art des Transports ist ganz erheblich dafür verantwortlich, was am Ende herauskommt. Die Unübersichtlichkeit der Datenmengen betrifft also nicht nur die User, sondern auch diejenigen, die mit der Verarbeitung der Daten zu tun haben, seien es nun menschliche oder nicht-menschliche Verarbeiter. -> Zweiter Einwand: Die Zunahme der Quantität der Daten ergibt keine Ordnung, ganz im Gegenteil: Je mehr Daten, desto mehr Übersetzungen, desto weniger Übersicht.

- Es ist ein Unterschied zwischen den beiden Bemerkungen

- Daten sprechen für sich

- Aus Daten ergeben sich Aussagen über die Welt

- In (1) wird suggeriert, dass sie eine Bedeutung haben, die man einfach aufnehmen könnte/sollte. In (2) wird dieser Gehalt in einen anderen Kontext übersetzt und daraus ergeben sich dann die von Euphon beschriebenen Verkettungen. Man muss aber bezüglich des Anfangs dieser Folge bedenken, dass Daten, wenn sie etwas sagen sollen, schon sprachförmig sein müssen. Das können sie nur sein, wenn wir sie verstehen oder zumindest versuchen können, sie zu verstehen. Selbst die einfachsten Daten sagen etwas, weil sie in Formulierungen entstehen, nicht in Algorithmen. --anna (Diskussion) 20:15, 2. Dez. 2015 (CET)

Mit “Output” ist das Resultat gemeint, das sich durch den Prozess ergibt. In Andersons Text wurde das Wort “Modell” verwendet, das mit einer bestimmten Art von “Wahrheit” in Verbindung gebracht wird. Dass sich “Wahrheit” ergibt ist nicht anzunehmen, eher, dass sich Wahrheiten ergeben, die abhängig von der jeweiligen Form der Übertragungsleistung sind. Solche Wahrheiten können höchstens Dispositive, in Foucaults Sinnn, sein. Daten sprechen nicht für sich selbst, sondern sie sprechen durch andere. Was sind diese Modelle wert, wenn abhängig vom Datenverarbeitungsprozess viele von ihnen entstehen? Korrelationen sind für sich genommen nicht genug, denn es muss mit entschieden werden, wie sie erzeugt wurden. -> Dritter Einwand: Korrelationen werden nicht eindeutig einordenbarer, wenn sie vermehrt werden. Je mehr Daten, desto mehr Möglichkeiten der Erzeugung von Korrelationen. Je mehr hinzuaddierte Möglichkeiten der Korrelation, desto weniger Übersicht ergibt sich.

Die Beschäftigung mit dem Phänomen der Big Data setzt die Annahme voraus, dass die Zunahme der Datenmengen eine Zunahme der Unübersichtlichkeit bedingt. Die Folgerung, es ergebe sich wie von Zauberhand Ordnung und Struktur, scheint überhastet und nicht schlüssig.

Was sich allerdings ergibt und meiner Meinung nach genauere Betrachtung verdient, ist die Möglichkeit, Kontroversen zu kartographieren. In dem Text Landscaping Climate Change von Rogers und Marres werden zwei Probleme von suchmaschinenbasierter Datenerhebung vorgestellt: “Moreover, it attempts to tackle the current inadequacy of Internet search engines, especially their inability to render source context and impart indications of the socio-epistemological value of information. (Rogers und Marres 1999 2) Die Vernachlässigung des Kontexts wurde bereits angedeutet: Daten werden erzeugt, ihre Prozessierung in Form von Übertragungen macht sie unübersichtlich, was eine Art Heuristik notwendig macht. “Whether or not the logics are intelligible to the user, ultimately he or she relies on his own personal framework of understanding to filter the flows anew.” (Rogers und Marres 1999 3) Der “Wert” des Ergebnisses ergibt sich nicht aus der zunehmenden Menge der Daten, sondern aus einer Bewertung heraus, die nicht von der Suchmaschine gewährleistet werden kann. Aus diesem Grund liegt es nahe, sich für Erziehung und Bildung der Nutzerinnen auszusprechen. Das ist allerdings ein anderes Thema. Was im bisher erörterten Zusammenhang interessant scheint, ist dass durch die Unübersichtlichkeit der Datenflut keine Einigung über den Kontext und über den “Wert” der daraus entstehenden Muster (Suchergebnisse) gibt. Das wurde auch von Anderson impliziert, als er davon sprach, dass sich diese Aspekte erst aus den Daten heraus ergeben müsse. Google ist hierbei aber nur ein Diskussionspartner in der Debatte darüber, wie die Kontexte und Werte konstruiert werden.

- Es gibt zwei verschiedene Arten der "Vernachlässigung des Kontexts". Einerseits (das ist eher Euphons Perspektive) erzeugen jeweils spezifische Umstände (durch Regelungen) Daten, die sich in der Folge netzartig ausbreiten. Ich möchte andererseits betonen, dass es im Datenbegriff liegt, dass sie formuliert werden. Das eine ist der Versuch, die jeweiligen Umstände der Formulierung namhaft zu machen, das andere der Hinweis, dass alle Daten Formulierungen sind. Sie entspringen nicht bloß den Umständen, sie sind als Daten "umständlich", will sagen sie sprechen nicht direkt. --anna (Diskussion) 20:33, 2. Dez. 2015 (CET)

- Ja, ich denke, da haben Sie recht. Ich habe das Schlaglicht auf die Vermengungen gerichtet und damit die Differenzierungen in den Hintergrund gestellt. Das liegt an der Art dieses Eintrags, in dem ich mich, zugegeben suggestiv, gegen den Plan von Chris Anderson stellen wollte. Mit etwas bescheidenerem Auftreten im Text wäre verbunden gewesen, auch die andere Seite zu zeigen. Es war mein Anliegen, mit dem Prozess zu beginnen und danach das Resultat in Betracht zu ziehen, obwohl es natürlich möglich ist, mit dem Resultat zu beginnen. Differenzierungen, Formulierungen bestehen, auch wenn sie nur über Umwege und Übersetzungen, also indirekt, gezeigt werden können, dem Prozess vorangehend schon implizit. “Implizit” setze ich in diesem Zusammenhang in die Nähe von dem, was Michael Polanyi über das “implizite Wissen” gesagt hat: die Differenzierungen bestehen, etwa wenn jemand an ein vertrautes Gesicht denkt, ohne die einzelnen Eigenschaften des Gesichts formulieren zu können. Das Wort “Eingabe” ist dem Wort “Eingebung” zumindest phonetisch recht nahe. Etwas als etwas erkennen ist eine Art Eingebung/Eingabe, die dadurch entsteht, dass das, was als etwas erkannt wird, sich dardurch zeigt, dass erkannt wird, was das ist, das erkannt wird.”wir wenden uns von etwas her etwas anderem zu und werden seiner im Lichte dieses anderen gewahr” (Polanyi 1985 20) - Oder: Einen Satz als Satz verstehen geht dem Verstehen des Satzes voraus, obwohl der Satz nur als Satz erkennbar ist, wenn erkannt wird, was er aussagt, also was erkannt wird, wenn etwas als etwas erkannt wird. Das scheint jetzt alles ein wenig paradox, aber wenn man die Umwege, die Übersetzungen ins Spiel bringt, dann kann man sich meiner Meinung nach vorstellen, weshalb die Daten nur indirekt geformt sind. Nichts ist an sich reduzierbar, aber alles kann reduziert werden, wenn Übersetzungsarbeit investiert wird, die sich als eine solche Arbeit auf etwas bezieht, das noch nicht direkt, sondern erst durch die Übersetzung formuliert werden kann (ein Beispiel dafür ist ein Polizeizeichner: er kann ein Gesicht als Zeichnung ausdrücken, das er nicht kennt, indem es ihm jemand beschreibt, der es kennt, es aber nicht in seiner Gänze beschreiben kann; ein anderes, etwas abstrakteres Beispiel - mit dem ich den Begriff “Wissen” etwas überdehne, das aber trotzdem dasselbe aussagt - ist das eines Eisberg, der schmilzt, weil sich die Atmosphäre erwärmt). Bei Chris Anderson wird die Übersetzungsarbeit vernachlässigt, deswegen ist das Resultat, das er sich verspricht, meiner Meinung nach nicht das, was durch die Methode die er vorschlägt erreicht werden kann. Vielleicht kann der in Andersons Text vorgeschlagene Vorgang mit einem Polizeizeichner verglichen werden, der das Gesicht desjenigen zeichnet, der ihm ein Gesicht beschreibt.

- Euphon (Diskussion) 12:04, 3. Dez. 2015 (CET)

Mit “Diskussion” ist hier nicht “Diskurs” gemeint. Kontexte und Werte sind keineswegs nur im Bereich des Sozialen, Symbolischen, Meinungshaften zu finden. Die datenbankmäßige Verarbeitung der Big Data geht über das Vermögen des Menschen hinaus, hieß es bei Anderson. Kontroversen können auch innerhalb von Aussagen auftreten, auch innerhalb von Übersetzungsvorgängen, die nicht nur von Menschen vorgenommen werden, sondern auch von Computern und die “Diskussionen”, die sich ergeben, sind nicht nur auf menschliche, sondern auch auf nicht-menschliche Gesprächspartner angewiesen. Einen Beleg für die Vermenung von Menschen und Artefakten in Diskussionsprozessen liefert die von Rogers und Marres vorgestellte Studie betreffend den Klimawandel und die Diskussion darüber im Web. (Rogers und Marres 1999 6). An einer solchen Diskussion sind nicht nur Menschen beteiligt, sondern auch Kühe, Autos, Thermometer, usw. Und diese sprechen für sich selbst nur durch andere Beteiligte.

Die Artefakte spielen also eine Rolle. So weit kann man mit Anderson mitgehen. Allerdings wäre es ein Fehlschluss anzunehmen, dass, nur weil Dinge “verlässlicher” scheinen als Menschen, sich durch sie Muster und Strukturen in Form von Gesetzen zeigen würden, die mehr “Wahrheit” bieten, als bisher erzeugt worden ist. Es ergeben sich höchstens Regeln, die wesentlich kontingenter sind als Gesetze. Menschen wie Artefakte addieren durch ihr Tun beiderseits in die Zirkulation des Diskurses eingehende “Wahrheiten” und sofern alle Beteiligten, der Kontext und die Entscheidung über den Wert der Ergebnisse zusammengetragen sind, lässt sich auch etwas über die wirkliche Welt sagen, allerdings als Ausgangsbasis für Debatten und nicht in Form von Ordnung, die sich laut Anderson von selbst ergeben soll. Was Anderson übersieht, ist dass diese Ordnung durch Kontroversen angeregt wird, die mühevoll durchgearbeitet werden müssen, was mal mehr, mal weniger, aber doch immer Kosten verursacht; von einer “sich von selbst ergebenden” Ordnung keine Spur. Eine alternative Anwendung von Big Data schlagen Rogers und Marres vor:

“In the search by individuals and groups for potential common ground, alliance-building, consensus-formation, and new substantive positions, the discursive maps, queried for the relations of positions taken by debating parties, would show who’s taking which stand, in reference, for example, to one or more future scenarios currently under consideration.” (Rogers und Marres 19)

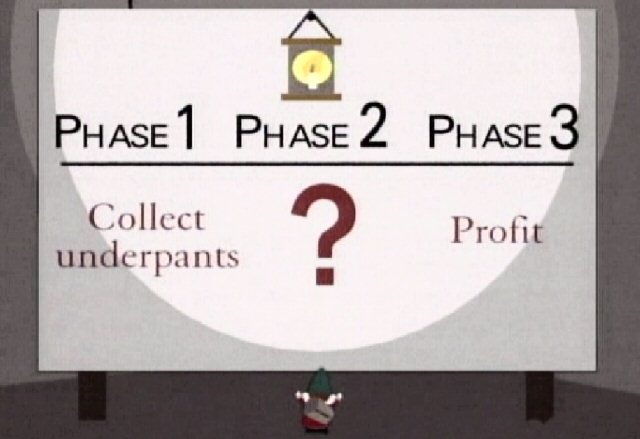

Ich kann mir eine kleine Polemik nicht verkneifen. Ich möchte Chris Anderson gegenüber nicht respektlos wirken, aber der von ihm vorgeschlagene Plan erinnert doch zu sehr an den Plan der Unterhosenwichtel, die bei einer beliebten Animationsfernsehserie vorkommen:

Literatur:

Lippmann, Walter (2009) - The phantom public; Transaction Publ.; New Brunswick, NJ

Obar, Jonathan A. (2015) - Big Data and the Phantom Public: Walter Lippmann and the Fallacy of Data Privacy; working draft; http://papers.ssrn.com/sol3/papers.cfm?abstract_id=2239188

Rogers, Richard und Marres, Noortje (2000) - Landscaping climate change: a mapping technique for understanding science and technology debates on the World Wide Web; http://govcom.org/publications/full_list/ROGERS_Marres_pus.pdf

Euphon (Diskussion) 10:40, 30. Nov. 2015 (CET)

Cyberinfrastructure in den Wissenschaften als ernstzunehmender Ansatz

Ein kurzer Nachtrag. Da Chris Anderson explizit von Wissenschaften spricht, möchte ich meinen generellen Vorschlag, Großdatenverarbeitung könnten eine wertvolle Hilfe beim Positionieren von Ansichten und beim Erklären von Handlungsorientierungen darstellen, was dabei hilft Kontroversten zu kartographieren, durch einen Beitrag ergänzen, in dem es um eine spezifische Wissenschaft geht: die Soziologie. Harold Garfinkels Gedanken folgend, die Soziologie habe sich selbst als blinden Fleck und sie müsse deswegen ihre eigenen Methoden analysieren, nahmen Kazunias, Sawyer und Østerlund eine Analyse der Cyberinfrastructure (CI) in den Sozialwissenschaften vor, also “the sharing of computational resources, distributed access to massive datasets, and the development of tools for collaboration and communication” (166; zitiert nach: Beaulieu, A. and Wouters, P. 2009. E-research as intervention. In E-research: Transformations in Scholarly Practices N.W. Jankowski, Ed. Routledge, New York, NY). Dabei setzten sie als Rahmen ihrer Analyse fünf von Wouters und Beaulieu formulierte Aspekte:

- 1. Epistemic diversity

- 2. Lack of consensus

- 3. Low technology research environment

- 4. Historically grounded solitary research practices

- 5. Specificity of writing and reading as features of knowledge creation

Wobei Kazunias et al. einen eigenen Aspekt addieren: die Erfassung schriftlicher wissenschaftlicher Dokumente, also nicht-digitalen (oder erst zu digitalisierenden) Anteilen an Strukturen wissenschaftlicher Erkenntnisproduktion.

1. Epistemic diversity: mehr noch als in den Naturwissenschaften wird deutlich, dass Episteme nicht einfach “eingesammelt” werden kann, sondern durch Kontroversen geformt wird. So zeigt sich, dass die Umgehensweisen der Wissenschaftler mit Cyberinfrastructures ganz unterschiedlich sind, abhängig von der jeweiligen wissenschaftlichen Praxis und kulturellen Einflüssen. Eine eindeutige Zuschreibung, was unter wissenschaftlicher Erkenntnisproduktion zu verstehen ist, sei deswegen nicht formulierbar.

2. Lack of consenus: Da viele Aufgaben, die in Cyberinfrastructures wahrgenommen werden, Konsens und eine gemeinschaftliche Herangehensweise voraussetzen, etwa Daten online zugänglich zu machen und Zugang zu diesen Daten zu gewährleisten, scheint es schwierig, bestimmte Wissenschaftssparten, wie die Sozialwissenschaften, an Cyberinfrastructures anteilig werden zu lassen.

3. Low level technology: den Autoren zufolge ist es üblich, dass Sozialwissenschaftler nicht denselben Zugang zu Rechnerressourcen haben wie etwa die Naturwissenschaften, da sich letztere zusammen mit “genealogies of research technologies” entwickeln, die den Forschern gemeinhin bekannt sind.

4. Solitary research practices: Sozialwissenschaftler arbetien eher individuell und unabhängig. Das ergibt sich aus dem Fakt, dass sie es eher mit qualitativen Untersuchungen zu tun haben, die nicht so leicht an mehrere Mitarbeiter verteilt werden können wie quantitative.

5. Writing and reading in knowledge creation: In den Naturwissenschaften verfestigen sich Handlungsabläufe, weil es formalisierte Prozeduren gibt, die in eine einheitliche Form gebracht werden können, wenn es um die Verfassung von Labornotizen und Papers geht. Dagegen ist die schreibbezogene Arbeitsweise der Sozialwissenschaften eher divers, unentschieden (unsettled) und offen für Interpretationen.

6. Documents Perspecitve: Die Autoren fügen den fünf Punkten einen Aspekt hinzu. Sie ziehen bei der Betrachtung alle möglichen Korrespondenztexte in Betracht (nicht nur Papers, sondern e-mails, memos, Reporte, Webseiten, also: “documents to accomplish social actions in particular situations” (169).

Als Vorbereitung auf eine größere Studie wurde mit einer kleineren Studie begonnen, deren Untersuchungsobjekte vier Soziologen waren.

- We used this as a pilot study and focused on both the indivudal and colaborative organizing practices of these social scientists through the lens of documents. To this end, we employed a document-centric methodology that involved mapping physical documents, digital desktops, and shared online interactions and repositories (i.e., “cloud-based”), automated tracking of desktops and online repositories, participant-generated images of physical documents and desktop, archival analysis of key documents, interview, behavioral inquiries and participant observation.” (169)

Die Ergebnisse ihrer Untersuchung beschrieben die Autoren wie folgt:

- We find that in our pilot study, the social scientists` digital infrastructure evolved organically over time and is largely based on providing ways to conncet indivdual work patterns. In this way, scientists are cobblers, latching together an organizational infrastructure with the materials at hand and layering it onto their existing work practices.” (172)

Am Ende geben die Autoren noch ein paar Anregungen, was für den Ausbau einer soziologenfreundlichen Cyberinfrastructure notwendig wäre.

- These ideas include: tools that aid the process of epistemological exchange and map conceptual issues; more robust common technoloiges such as threading tools for email, applications to monitor document changes; customizable document sharing platforms; “practices.mapping” visualization tools, applications to track provenance and tag documents to create a “working collection”, and a focus on the materiality of documents in scholary research practices. […] While more work needs to be doen, our initial findings seem to confirm those who argue that a view of CI which emphasizes data and tools fails to see the larger set of documents and the evolving negotiations embodied in them as core virtual organizing in social science. The document-centric approach described in this paper helps illustrate that CIs are heterogeneous, evolving and incomplete. Seen this way, CI`s change over time as they shape and are shaped by the social, technical, and disciplinary milieu in which they exist. Documents, social practices, and the form and functions of the available technolgies, thus guide, but do not predict the forms and shape of future actions and events.” (172)

Bezogen auf das in dem vorigen Eintrag Gesagte könnte man ergänzend Anderson entgegnen: Es gibt nicht die Wissenschaft, sondern verschiedene Wissenschaften. Auch wenn die Einteilung in Natur- und Sozialwissenschaften viel zu oberflächlich ist, reicht schon diese grobe Unterscheidung aus, um Andersons Plan ins Wanken zu bringen. Die Arbeit der Sozialwissenschaften ist qualitativ, individuell und interpretationsbezogen und damit nicht ohne weiteres quantifizierbar.

Aus der Gegenüberstellung der vorgestellten CIs im Sozialwissenschaftsbereich und Andersons Plan ergibt sich eine Möglichkeit zu interpretieren, wem die Verantwortung zugesprochen wird. Wer bürgt in Andersons Fall für die Wahrheit der Resultate? Wer ist für das was abläuft verantwortlich zu machen? Es zeigt sich ein paradoxes Bild: Anderson spricht gar nicht so sehr für die Technikbegeisterten, sondern eher für jene, denen unwohl wird bei dem Gedanken, dass ihr Desktop überwacht wird und die sich deswegen bereitwillig von den Big Bad Data mit Schaudern abwenden und ihnen die ganze Arbeit delegieren, nur damit sie nicht Gefahr laufen, in den Verarbeitungsprozess zu gelangen und von der unheimlichen Maschinerie des “Neulands” zermalmt zu werden. Das ist ähnlich erstaunlich wie, dass der Standpunkt der NRA eigentlich nicht jenen entspricht, die Waffen anbeten, wie die Samurai ihre Schwerter, sie als etwas Besonderes empfinden, ihnen Namen geben, von ihrem ganz eigenen “Charakter” von ihnen als ihre “Beschützer” sprechen und die mit ihnen mächtig wedeln, wenn behauptet wird, “nicht Waffen töten Menschen, sondern Menschen!”, was die Waffen zu bloßem Zeug werden lässt; eine Einstellung, die eher Waffengegnern zugesprochen werden könnte. Oder dass Ökologen über die Natur sprechen, ohne dabei zu bedenken, dass jede klare Formulierung einen Schritt weg von der “Natur” bedeutet, weil ein Begriff, eine Definition erst anhand von Übersetzungen, die schlussendlich nichts mehr “Natürliches” an sich haben, erzeugt werden kann. Es ist ein bemerkenswertes Verhalten, wenn man, wie in Andersons Fall eher Partei für die Technikgegner (die sich möglichst von dieser abgrenzen wollen) ergreift, dabei aber die Verantwortung ganz der Technik übergibt, wenn man, wie die Befürworter der NRA jedem Schießprügel einen Namen gibt, diesen aber dann behandelt wie ein bloßes Ding, wenn man wie die Umweltschützer die Natur zu bewahren versucht, indem man zu wissen vorgibt, worum es sich dabei handelt, obwohl die Konstruktion dessen, was “Natur” bedeutet, in den Händen derer liegt, die gar nichts mit ihrem Schutz zu tun zu haben glauben, oder die sich nicht darüber einigen können, was denn nun mit der “Natur” zu machen sei.

Umabhängig von diesem, für eine Technologiebefürworter, der Anderson zu sein scheint, relativ seltsamen, Standpunkt ist jedoch zu sagen, dass Big Data den Wissenschaften - meiner Meinung nach Sozial- und Naturwissenschaften - im Verbund mit agierenden Personen (und deren vielfältigen, auch nicht-digitalen Arbeitsprozeduren - von der Schwierigkeit Manuskripte oder handschriftliche Vermerke datenbanktechnisch zu verarbeiten wurde in der LV schon gesprochen) eine Hilfe sein kann, um Positionen zu klären, Zugänge zu Options- und Verweisungszusammenhängen herzustellen, um den Wissensproduktionsprozess stützend Probleme und Kontroversen aufzuzeigen, usw, Es kann jedoch nicht davon ausgegangen werden, dass Wissenschaft ohne Wissenschatler ablaufen soll. Es scheint überhaupt der unsinnig zu sein zu, dass sich Wissenschaft in einer Welt abspielen soll, die den Menschen nicht betrifft. Es scheint mir eher wünschenswert, dass in den Wissenschaften mit der Technik gearbeitet wird und nicht, dass sie den Wissenschaftler ersetzt. Als wissenschaftliche Mitarbeiter wiederum bieten die vielen “Helferleins”, um mit einem Augenzwinkern an Daniel Düsentrieb und seinen lustigen kleinen glühbirnenköpfigen Assistenten zu erinnern, eine zu große Chance, als dass man sie entweder generell verteufelt und/oder sich möglichst von ihnen befreit, um sie im Stillen ihre eigene Arbeit vollbringen zu lassen, von der der Mensch dann proditieren soll. - Marx hatte eine ähnliche Idee: die Entlastung des Menschen von der Arbeit durch die Maschine, auf dass die Menschheit wieder sie selbst werden könnte. Allerdings zu dem Preis, dass Mensch und Maschine vollkommen voneinander abgekoppelt und sich gegenseitig als absolut fremd empfindend angenommen werden.

Im Mythos von Ikaros entspricht der Text von Kuzians et al. eher der Figur des Daidolos und Anderson eher der Rolle von Ikaros. Während der Tüftler am Entwurf des Fluges seines Sohnes arbeitet, der die Flügel ebenso wie den Ikaros und ebenso den Kontext, den ein mit Hilfe der Flügel fliegender Ikaros und die auf dieses Projekt einwirkenden Einflüsse beeinhaltet - und für einen Teil dieses Projekts Verantwortung übernimmt -, freut sich Ikaros auf das Fliegen und vertraut ganz - und zu sehr! - des Vaters Gerätschaften. Hätte Daidalos selbst die Flügel angelegt, er wäre wohl nicht zu hoch geflogen, er hätte aber auch nicht aus Furcht vor dem Fliegen einen ferngestuerten fliegenden Schlitten gebaut, auf dem ein elektronischer Geschenkebringer sitzt.

Ich wünsch frohe Weihnachten und einen guten Rutsch!

Literatur:

Kaziunas, Elizabeth, Sawyer, Steve, Østerlund, Carsten (2011) - Social Scientists, Documents and Cyberinfrastructure: The Cobbler`s Children or the Missing Masses?; ACM; New York

Euphon (Diskussion) 11:23, 23. Dez. 2015 (CET)

"…es geht halt doch nicht ohne…" - Bruno Latour, ANT und AIME

Vielen Dank für die Behandlung Latours in der letzten LV und für die rege Diskussion! Es bleibt mir nur noch ergänzend zu erwähnen, dass Latour seine Epistemologie an William James und dessen “radikalen Empirismus” [1] orientiert, die keinen “logical space of reason” annimmt. Für Latour werden Daten erhoben und im selben Moment die Theorie zu den Daten konstruiert. Damit kann Latour in die Nähe von Chris Anderson gebracht werden. Das fällt nicht schwer, wenn man sich einen der neuesten Texte ansieht, die Latour zum Thema des Einsatzes von Big Data in der Soziologie mitverfasst hat. [2] (Ich möchte betonen, dass der Text wenig mit einem Text Latours zu tun zu haben scheint; weder vom Stil, noch vom Thema her, obwohl sein Name offensichtlich in der Autorenleiste steht.) Aufgrund dieser Faktenlage scheint der Fall klar zu sein und ein Misstrauen gegenüber Latour berechtigt. Man könnte zudem sagen, dass Latours Philosophie sophistische Züge aufweist und sein Denken naiv ist. (Ein Begriff mit dem er selbst an einigen Stellen seines Werkes kokettiert.)

Allerdings stimmt dies alles nur, wenn man vom Latour vor der Jahrtausendwende spricht. Seit sich der Autor von der Actor-Network Theory (ANT) abgewendet hat, tauchen in seinen Texten Begriffe wie “Plasma” auf, was soviel bedeutet wie, “that which is not yet formatted, not yet measured, not yet socialized, not yet engaged in metrological chains, and not yet covered, surveyed, mobilized, or subjectified” (Latour 2005 244). Er spricht seit der Abkehr von “Existenzweisen” und “Propositionen” (Latour 2013) und davon, Vertrauen in die Institution der Wissenschaften zurückzugewinnen (Latour 2013 Einleitung). Das klingt nun nicht mehr nach dem Latour der multidirektionalen Trajektorien und des Konstruktivismus. Der Philosoph der Science and Technology Studies (STS) und der ANT wurde abgelöst durch den der AIME (der übliche Abbreviationismus der Technikphilosophie). Die frühere, prozesshafte Perspektive wurde durch die der “Seinsweisen" ergänzt. (Ein Begriff übrigens, der von Rudolf Bultmann, einem Freund Heideggers und eine der Hauptfiguren in der Dissertation Latours (Latour 2010 4) benutzt wurde.)

Das ist alles recht problematisch, denn Latour scheint nicht zu verraten, in welchem Zusammenhang diese beiden Perspektiven zueinander stehen. Latour hebt zwar die ANT auf, indem er sie als Modus [NET] in seinen neuere Philosophie der Existenzweisen übernimmt und ihm kann zudem zugeschrieben werden, dass die Existenzweisen schon in seinen frühesten Texten zu finden sind (Schmidgen, in: History of Science Society Vol. 105/3 2014 674), aber es hilft nichts, wenn kein Bezug zwischen den beiden Sichtweisen hergestellt werden kann. Dann kann Latour ein “reflexiver Regress” (Schulz-Schaeffer, in: Weyer 2000 202) unterstellt werden, wenn es um die Definition des Akteurs geht, wodurch Fragen unbeantwortet bleiben, wie zum Beispiel danach, wer Verantwortung übernimmt, wenn auf den Anruf eines anderen geantwortet wird, ohne in einem Regress zu versinken.

In dem Kommentar zum Kommentar im vorletzten Beitrag habe ich durch den Hinweis auf Michael Polanyis Text “Implizites Wissen” bereits darauf hinzuweisen versucht, dass man den Prozess auch vom Resultat her denken kann. Ich bin der Meinung, dass diese “Vorlage” bei Latour auffindbar ist, auch wenn der Autor selbst leider die Arbeit anscheinend nicht erledigt hat, dies erkenntlich zu machen und Prozess und Resultat zu verbinden. Polanyi ist hier allerdings nur ein Platzhalter für eine Philosophie, die an diesem Punkt erst eingesetzt werden muss und die sich in verschiedenen Ansätzen wiederfindet, von denen der richtige gefunden werden muss. Der richtige Ansatz ist der, welcher am ehesten die beiden Herangehensweisen von Latour miteinander in Verbindung zu bringen vermag. (Das ist ein Sachverhalt, mit dem ich mich in meiner Dissertation auseinandersetze.)

In diesem Lichte möchte ich nochmals auf meinen Text hinweisen, der sich explizit gegen die Herangehensweise von Chris Anderson stellt. Ich begründe diese Unterscheidung auf einer jeweiligen Verortung in der Technikphilosophie von Latour und Anderson. Man kann Anderson nicht unbedingt als Technikphilosophen bezeichnen, aber er ist hier in diesem Zusammenhang der Lehrveranstaltung eine interessante Inspiration gewesen, deswegen können die beiden Autoren in diesem Rahmen zueinander in Beziehung gesetzt werden. Der Unterschied ist, dass Anderson klar eine technikdeterministische Perspektive zugeschrieben werden kann. Diese Zuweisung beruht darauf, dass der Autor annimmt, dass die Technologien ihr autonomes Eigenleben entwickeln und dass sie einen Einfluss auf die Gesellschaft ausüben kann (so wie es Heidegger - unter anderem auch von Latour - eventuell fälschlicherweise (vgl. Lin/van Brakel, in: Continental Philosophy Review 2014) zugesprochen worden ist). Latour ist nun hingegen zwar nicht gerade das Gegenteil eines Technikdeterministen, also jemand, der Technologie für “applied science” (Bunge, in: Technology and Culture 1966) hält, aber er gehört zum Zirkel der STS. (Dort ist, ich sage es salopp, die Interdiszipliniarität zu Hause und ein Autor wie Latour gern gesehen.) Die STS spricht entgegen der beiden eben vorgestellten Sichtweisen von einer “Technoscience”. Mit diesem Begriff ist eine symbiotische Interrelation der beiden Bereiche Wissenschaft und Technik vorausgesetzt, bei der keines der beiden Gebiete dem anderen gegenüber eine Priorität besitzt (vgl. Ihde, in: Companion 2009 51ff).

Chris Anderson kann, so möchte ich behaupten, das Konzept einer gegenseitigen Wechselwirkung, wie ich sie in dem Beitrag angedeutet habe, der das Schlaglicht auf den Verbund gelegt hat, nicht zugesprochen werden.

Es stimmt, dass Latours Epistemiologie durch Sellars kritisiert werden kann. Ich möchte allerdings darauf hinweisen, dass Latour in diesem Text (Latour 2004) auf die Epistemiologie von Whitehead hingewiesen hat. Ich bin noch nicht ganz sicher, ob Whitehead der Kritik Sellars entgehen kann, vorerst würde ich behaupten, dass dies nicht der Fall ist (obwohl die "eternal objects" vielleicht ein Weg wären, "Kategorien" zu involvieren). Allerdings bietet sich trotzdem eine spannende Beschreibung der Interpretation Isabelle Stengers` und Vinciane Desprets der Epistemologie von Whitehead. Allerdings nur derjenigen, die sich mit einer recht üppigen Metaphysik anfreunden kann, die zwar sehr gut durchdacht, aber leider auch ausgewiesen idiosynkratisch ist. (Eine Eigenschaft eines Autors übrigens, die Latour an vielen seiner Vorbildern bewunderte; Gabriel Tarde, Harold Garfinkel, Michel Serres, u. a., zu denen vielleicht auch Heidegger gehören würde, denn die beiden könnten sich eventeull gut verstehen (Harman 2009), wenn Latour Heidegger nur ein wenig genauer gelesen hätte (Conty 2013).)

- Der "space of reason" ist nicht einfach ein postulierter eigenständiger Bereich, der dem Bereich ständig wechselnder aus Situationen entstehenden Impulsen gegenübergestellt wird. Er ist intern strukturiert, es herrschen Verstehens- und Verfahrensregeln im Unterschied zu ad hoc Organisationen, die locker wieder aufgelöst werden können. Ich bin versucht, die "Willkommenskultur" als (positiv) plastische Anpassung an externe Herausforderungen anzusehen, die von zahlreichen Akteuren aktuell ausgehandelt wird, allerdings aber ohne interne, politische Stabilität bleibt. Der "Raum der Vernunft" sieht in diesem Fall z.B. vor, dass Personen, die sich ihrer Personaldokumente entledigen, um nicht zurückgewiesen werden zu können, nicht fault de mieux als Asylanten anerkannt werden können. Oder dass etwas dagegen zu unternehmen ist, dass Flüchtlinge in Seenot ihre Schlauchboote zerstören, um gerettet werden zu müssen. Ein Stichwort dazu ist Gesinnungsethik versus Verantwortungsethik [3]. Die verrufene Bürokratie ist unter anderem ein Stabilitätsfaktor.

- --anna (Diskussion) 15:13, 31. Jan. 2016 (CET)

Es liegt mir fern, Latour entschuldigen zu wollen, denn man hat schon seine liebe Not mit der Lektüre seiner Texte. Aber genauso wie man sagen kann, dass Latour frischen Wind in die Diskussion gebracht hat, es aber dann doch nicht ohne “Vorlagen” und “Schablonen” geht, so kann man auch sagen, dass jede wissenschaftliche Beschäftigung mit einer Thematik zwar richtige Fragen stellen soll, es aber auch nicht ohne eine interessante Fragestellung geht. Latours Philosophie ist für interessante Fragestellungen ein ergiebiger lebendiger Steinbruch.

Literatur:

Bunge, Mario (1966) - Technology as Applied Science, in: Technology and Culture, Vol. 7/3, 329-347; J. Hopkins University press; http://www.jstor.org/stable/pdf/3101932.pdf?acceptTC=true

Conty, , Ariane (2013) - Techno-phenomenology: Martin Heidegger and Bruno Latour on how phenomena come to presence, in: South African Journal of PhilosophyVol. 32/4, 311-326; http://www.tandfonline.com/doi/pdf/10.1080/02580136.2013.865099

Harmna, Graham (2009) - The prince of Networks: Bruno Latour an dMetaphysics; re.press; Melbourne; http://www.re-press.org/book-files/OA_Version_780980544060_Prince_of_Networks.pdf

Ihde, Don (2009) - Technology and Science, in: Berg Olsen, Jan K., Pedersen, Stig A., Hendrick, Vincent F. [Hrsg.] - A Companion to the Philosophy of Technology; Blackwell; Chichester, West Sussex

Latour, Bruno (2013) - An Inquriy into Modes of Existence: An Anthropology of the Moderns; Harvard University Press; Cmabridge; www.modesofexistence.org

The AIME Project; Latour, Bruno (2013) - Another Way to compose the Common World: Paper prepared for the session ‘The Ontological Turn in French Philosophical Anthropology’: An Executive Session of the AAA Annual Meeting, Chicago, November 23, 2013, in: Journal of Ethnographic Theory Vol. 4/1; http://www.bruno-latour.fr/sites/default/files/132-AAA-CHICAGO-PHIl-ANTH-2013.pdf

Latour, Bruno (2012) - Biography of an Inquriy: About a book on Modes of Existence, in: Social Studies of Science; Vol. 43/2, 287-301; http://www.bruno-latour.fr/sites/default/files/126-KARSENTI-AIME-BIO-GB.pdf

Latour, Bruno (2010) - Coming out as a Philosopher: Lecture for the reception of the Siegfried Unseld Preis, in: Social Studies of Science 2010; SAGE; http://www.bruno-latour.fr/sites/default/files/114-UNSELD-SSS-GB.pdf

Latour, Bruno (2004) - How to talk about the Body? The normative Dimension of Science Studies, in: Body & Society, Vol. 10/2-3, 205-229; http://bruno-latour.fr/sites/default/files/77-BODY-NORMATIVE-BS-GB.pdf

Latour, Bruno (2005) - Reassembling the Social: An Introduction to Actor-Network-Theory; Oxford University Press; New York; http://dss-edit.com/plu/Latour_Reassembling.pdf

Lin, Ma und van Brakel, Jaap (2014) - Heidegger`s Thinking on the “Same” of Science and Technology, in: Continental Philosophy Review, Vol. 47/1; http://link.springer.com/article/10.1007/s11007-014-9287-z/fulltext.html

Schmidgen, Henning (2014) - Review: An Inquriy into Modes of Existence, in: Isis, Vol. 105/3, 673-675; http://www.jstor.org/stable/10.1086/679177?sid=primo&origin=crossref&seq=1#page_scan_tab_contents

Schulz-Schaeffer, Ingo (2000) - Akteur-Netzwerk-Theorie: Zur Koevolution von Gesellschaft, Natur und Technik, in: Weyer, Johannes [Hrsg.] (2000) - Soziale Netzwerke. Konzepte und Methoden der sozialwissenschaftlichen Netzwerkforschung, München u.a.: Oldenbourg, S. 187-209.;https://www.uni-due.de/imperia/md/content/soziologie/akteurnetzwerktheorie.pdf

(Die mit einer url versehenen Texte können übrigens via uni-vpn kostenlos als Volltext heruntergeladen werden.)

Euphon (Diskussion) 15:17, 21. Jan. 2016 (CET)