Benutzer:Matthieu/WS08-OSP-Zsfg

Inhaltsverzeichnis

- 1 Download

- 2 Open Source Philosophie

- 3 Zusammenfassung

- 4 Einleitung

- 5 Stoffzusammenfassung

- 5.1 Einheit I - Lippenbart und Remixing

- 5.2 Einheit II - Gelebte Open Source Philosophie

- 5.3 Einheit III - Geistiges Eigentum und Verkäuflichkeit

- 5.4 Einheit IV - Redekunst und Fachwissen

- 5.5 Einheit V - Überleitung zur Gegenwart

- 5.6 Einheit VI - Handwerksgeschichte, GNU und Linux

- 5.7 Einheit VII - OSP praktisch

- 5.8 Einheit VIII - Das theoretische Potenzial

- 5.9 Einheit IX - Wissensökonomie und Wachstumstheorie

- 5.10 Einheit X - Wissensökonomie und Eigentum

- 5.11 Einheit XI - Intellectual Property und Innovationen

- 5.12 Einheit XII - Conclusio

Download

| Dokument | Link |

| herunterladen | |

| LaTeX-Quelldateien | herunterladen |

| Wiki-Quelltext | herunterladen |

Open Source Philosophie

- a0600222 Christian Sieberer nach Prof. Herbert Hrachovec

Zusammenfassung

Dieses Dokument ist eine Abschlussarbeit zur von Prof. Herbert Hrachovec im Wintersemester 2008/09 gehaltenen Vorlesung "Open Source Philosophie". Nach einführenden Betrachtungen über die Informatik an sich beinhaltet es eine Stoffzusammenfassung der Vorlesung, die auf den online verfügbaren Audio-Mitschnitten der Vorlesungseinheiten und den entsprechenden Transkripten im Philo-Wiki basiert und auch eigene Kommentare enthält.

Einleitung

Zum Selbstbild der Informationstechnik

Nach zweieinhalb Jahren im Informatikstudium will ich mir vorbehalten, unser Umfeld ausreichend genau beobachtet zu haben, um einige Grundaussagen über unsere Wissenschaft und die darin vorherrschenden Mentalitäten treffen zu können. Ich tue das, weil ich der Meinung bin, dass die Technik, mit der Menschen sich jahrelang beschäftigen, diese eingehend formt und deren Denkweisen dabei verändert. Die Informatik ist keinesfalls ohne Philosophie; sie hat jedoch Prinzipien, die - wie es in der Vorlesung bzw. den Transkripten genannt wird - deutlich von denen Unserer Philosophie, wie wir sie heute kennen abweichen. Und will man das Phänomen Open Source verstehen, kann es nicht verkehrt sein, zunächst einen Blick auf die Informatik an sich zu werfen.

(Bemerkenswerterweise wird freie und Open Source Software erst im dritten Jahr des Informatikstudiums explizit behandelt, und zwar in der Vorlesung "Sozial- und Geisteswissenschaftliche Grundlagen der Informatik")

Natürlich ist die folgende Liste keinesfalls vollständig; sie soll vielmehr dazu dienen, die Kultur der Informatik über die Implikationen der Technologie verständlicher zu machen.

- Informatik ist per definitionem interdisziplinär.

Unsere Fachrichtung benutzt gerne Abkürzungen und hat daher auch eine solche zum Namen gewählt. Informationstechnik impliziert natürlich, dass die zu bearbeitende Information - zumindest wenn sie einen praktischen Nutzen haben oder erzeugen soll - aus einem Anwendungsbereich kommt, den die Naturwissenschaften ebenso bilden können wie die Medizin, die Kommunikationswissenschaften oder die Betriebswirtschaft.

Meiner Meinung nach ist es daher keinesfalls abwegig, sondern geradezu folgerichtig, Philosophie und Informatik auf der Ebene von Konzepten und Phänomenen wie Open Source zu verbinden. - Wir müssen alles formalisieren.

Computer sind Maschinen und werden es mit der gegenwärtigen Technik auch bleiben; selbst wenn wir derzeit gerne von "semantischen Informationssystemen" sprechen und hochtrabend behaupten, dass Rechnernetze Informationen nicht nur interpretieren, sondern auch verstehen könnten - hier spielen Kontextdefinitionen über das weithin bekannte XML (Extendible Markup Language) eine wichtige Rolle - so kann ein Computer doch nicht mehr tun, als Zeichen zu lesen (Eingabe), nach genau spezifizierten Regeln zu verändern (Verarbeitung) und auszugeben.

Zu diesem Zweck sind alle Computer in der Lage, mit einer Reihe von Regelsätzen (Grammatiken) umzugehen, die hierarchisch angeordnet sind und die Sprachen definieren, in denen wir Programme schreiben können. Eine relativ einfache Grammatik bestimmt etwa die Bedeutung von elektronischen Schaltkreisen; eine etwas komplexere die der Maschinen- oder etwa Assemblersprache, die für uns Menschen im Vergleich zu den höheren Sprachen wie C++, Fortran 90 oder Java nur recht schwer zu lesen sind.

Eines ist jedoch all diesen Sprachen gemeinsam: Sie sind vollständig formal definiert. Das bedeutet, dass auf syntaktischer Ebene alle Regeln völlig exakt einzuhalten sind, um ein Programm - egal in welcher Sprache es geschrieben sein mag - zum Laufen zu bringen (und zwar mit genau dem semantischen Inhalt, den der Programmierer durch seinen Code vorgibt; ungewünschte und Fehlfunktionen eingeschlossen). Wenn wir also einen Ablauf aus einem Anwendungsgebiet durch den Computer unterstützen wollen, müssen wir diesen Ablauf zuallererst formalisieren, um ihm dem Computer mitteilen zu können. - Wir sehen die Welt so einfach wie möglich.

Glücklicherweise besteht die Welt, in der wir uns im Alltag bewegen, nicht aus 0 und 1; da ein Computerspeicher aber auf diese beiden Zahlen beschränkt ist, wird jedes Programm durch die oben genannte Hierarchie an Grammatiken letztendlich in eine Folge aus diesen beiden Zahlen gebracht, was eine Reihe von Konsequenzen mit sich bringt:- Je näher die Repräsentationsarten von Daten und Programmen an dieser "natürlichen Computersprache" sind, umso effizienter (= schneller) ist in der Regel deren Ausführung.

- Je simpler die von Programmen ausgeführten Operationen, umso effizienter die Programme. Auf der physischen Ebene lassen sich alle Programme durch eine Abfolge von nur drei Grundbausteinen darstellen: Die Boole'schen Operatoren AND, OR und NOT.

- Je weniger Operationen eine Programmiersprache anbietet, umso effizienter sind deren Programme. Konzeptuell lassen sich alle Programme als Kombinationen von vier Grundoperationen darstellen.

In der Regel profitieren wir also von Vereinfachungen und gehen in der Praxis nach Prinzipien vor, die ihre Effizienz daraus beziehen, uns alles so einfach wie möglich und nur so komplex wie nötig gestalten zu lassen - wir sind also professionelle Minimalisten (KISS - Keep it simple and stupid) und verwenden so oft wie möglich abstrahierende Modelle und Diagramme, um Sachverhalte darzustellen.

- Wir sind doch keine Programmierer.

Korrekt müsste es eigentlich heißen Wir sind nicht nur Programmierer, doch die erste Fassung ist als beruhigend gemeinter Ausspruch zwischen Hörern von Informatikvorlesungen deutlich häufiger anzutreffen. Der Einfachheit halber sei im Folgenden jeder Vorgang, der dem Computer etwas Ausführbares beibringt, als Programmierung bezeichnet, auch wenn wir dabei nicht immer selbst klassischen Code schreiben (je nach Einstellung: müssen/dürfen). Und wenn - etwas überspitzt ausgedrückt - wir als studierte Informatiker uns auch oft als zu gut zum Programmieren sehen, hat doch alles, was wir tun, mit (Programm-) Code zu tun und verlangt eine gute Kenntnis von Programmiertechnik und deren Grenzen. Was wir auf jeden Fall auch sind: Analytiker, Architekten, Mathematiker, Modellbildner, Systemdesigner, Teamarbeiter - und, ob wir wollen oder nicht: der Computer stellt ein brillantes Mittel zur Rationalisierung von Abläufen in einem Unternehmen dar. - Ohne uns läuft nichts.

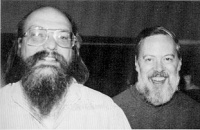

Sir Tim Berners-Lee (links) und Robert Cailliau, Pioniere des WWW. Quelle: http://www.w3.org/2005/06/W3C10-Photos/cailliau-bernerslee.jpg

Sir Tim Berners-Lee (links) und Robert Cailliau, Pioniere des WWW. Quelle: http://www.w3.org/2005/06/W3C10-Photos/cailliau-bernerslee.jpg

Ein beliebtes Beispiel, um die Bedeutung von Informations- und Kommunikationstechnik (IKT) zu verdeutlichen, ist die Tatsache, dass keine Bank der Welt länger als 48 Stunden ohne sie überleben könnte. Das Design, die Programmierung und der Betrieb von IT-Systemen bringt also eine Menge an Verantwortung mit sich, die zwar in der Praxis nicht an die ausführenden Einzelpersonen zurückübertragen werden kann (dafür gibt es Verantwortungsträger), die aber trotzdem ständig zu bedenken ist. (Zum Management von Risiken existieren in der IT selbstverständlich vielfältige Ansätze, wie etwa sogenannte IT-Management-Frameworks, siehe zum Beispiel ITIL oder COBIT.)

Eine Grundhaltung, die ausdrückt, wie Selbstorganisation in der Kultur der informatischen Teamarbeit - und damit besonders in Open-Source-Projekten - aussehen kann, wurde von Robert Cailliau, einem der Väter des WWW, folgendermaßen formuliert:

- "We do not believe in kings, presidents and voting. We believe in rough consensus, factual approach and running code."

(Robert Cailliau; ähnlich von David D. Clark, Mitglied der Internet Engineering Taskforce (IETF))

- "We do not believe in kings, presidents and voting. We believe in rough consensus, factual approach and running code."

Informatik und Philosophie

Ich muss gestehen, mit Philosophie im klassischen Sinne nur insofern vertraut zu sein, als ich in der Oberstufe des neusprachlichen Gymnasiums ein Schuljahr lang ein gleichnamiges Unterrichtsfach besucht habe. Vergleiche ich aber die Vorlesung OSP mit denen aus Informatik, so fällt mir ein Unterschied besonders auf:

(Ich beschreibe hier natürlich meine persönliche Sichtweise - es handelt sich also um Beobachtung und Meinung, nicht um Fachwissen; auch wenn ich um Neutralität bemüht bin, muss ich daher darauf hinweisen, dass man zu jedem der in diesem Kapitel genannten Punkte abweichende Meinungen finden wird.)

- "Da dies mein erster Beitrag in diesem Wiki ist, sei es mir vorab erlaubt, als bislang staunend beobachtender Informatikstudent einige Bemerkungen vorauszuschicken: Zuallererst - ich bin begeistert von der Vortrags- und Diskussionskultur in dieser Gemeinschaft, die mir im Vergleich zur gewohnten von außergewöhnlicher Empathie, Behutsamkeit und zugleich Produktivität und Zielstrebigkeit geprägt zu sein scheint."

(Philo-Wiki)

- "Da dies mein erster Beitrag in diesem Wiki ist, sei es mir vorab erlaubt, als bislang staunend beobachtender Informatikstudent einige Bemerkungen vorauszuschicken: Zuallererst - ich bin begeistert von der Vortrags- und Diskussionskultur in dieser Gemeinschaft, die mir im Vergleich zur gewohnten von außergewöhnlicher Empathie, Behutsamkeit und zugleich Produktivität und Zielstrebigkeit geprägt zu sein scheint."

- Im Gegensatz dazu läuft Kommunikation im Bereich der Informatik vielfach kurz ab und verwendet einfache Begriffe, um im gegebenen Kontext möglichst unmissverständlich zu sein;

- Den Prozess der Diskussion, der in der Philosophie den Reiz auszumachen scheint und der bereits dadurch, dass er überhaupt stattfindet, Wert generiert (um es banal auszudrücken), empfinden wir in Vorlesungen oft als störend;

(eine typische Szene aus einer Informatik-Vorlesung: Haben Sie Fragen? - keine Reaktion - Gut, wer von Ihnen hat das jetzt verstanden? - keine Reaktion - Wer hat es nicht verstanden? - dito - Also, Sie überlegen noch. - vereinzeltes Nicken. - Ebenso wie wir eine neue Perspektive auf ein "gelöstes" - also mit derzeitigen Mitteln zufriedenstellend genau berechenbares - Problem eher als redundant denn als bereichernd wahrnehmen;

- Unsere wissenschaftlichen Arbeiten lesen sich oft äußerst trocken, vor allem wenn sie auf Deutsch verfasst sind;

- Wir verwenden gängigerweise Powerpoint-Foliensätze als Vorlesungsskripten;

- Und viele von uns unterschätzen, wie wichtig eine ansprechende Präsentation ist, um guten Arbeitsergebnissen überhaupt die Chance zu geben, bemerkt zu werden.

Über diese Zusammenfassung

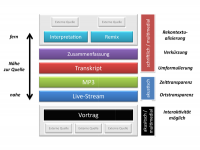

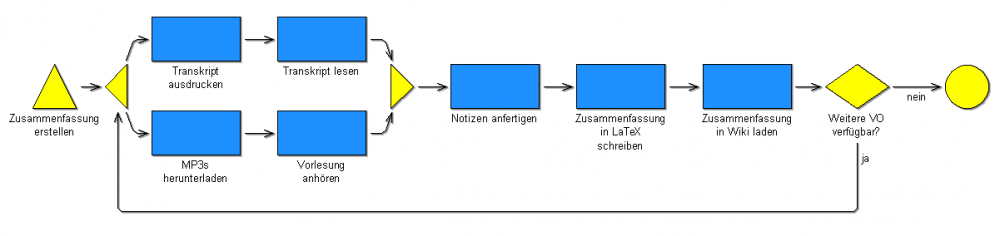

Ich habe weiter oben bereits mehrmals das Wort "Modell" erwähnt und seine Wichtigkeit für die Informatik hervorgehoben. Ich möchte die beiden Disziplinen am folgenden Beispiel noch einmal zusammenbringen, weil ich glaube, dass so der grundlegende Unterschied recht deutlich wird: Die folgende Abbildung stellt dar, wie ich die Stoffzusammenfassung erstellt habe.

Ich gehe davon aus, dass diese Darstellung an sich selbsterklärend ist und viel kürzer und präziser, als es ein Stück Text sein könnte - das ist sozusagen unsere Kommunikationsstrategie, die selbstverständlich nicht ganz ohne Probleme ist: Ich muss quasi einen Kontext definieren, eine Granularität festlegen und dem Betrachter ein bisschen nachhelfen, wie genau er das Modell nehmen darf - und das ist jedem Modell inhärent, da jedes Modell eine Abstraktion (Verkürzung) eines abgebildeten Sachverhalts enthält.

Ich muss auf der pragmatischen Ebene klärend auf den Betrachter einwirken; sonst könnte nämlich jemand kommen und sagen: "Gut, du hast also parallel die MP3s heruntergeladen und die Transkripte ausgedruckt - aber für beides wirst du zumindest ein paar Mausklicks und Handgriffe gebraucht haben, du hast einen Zielordner für die Downloads ausgewählt und auch das Papier in den Drucker gelegt, das wirst du wohl kaum gleichzeitig gemacht haben können. Und was hast du getan, wenn dir währenddessen der PC abgestürzt ist?". Und ich kann dann entgegnen "So genau darfst du das nicht nehmen, ich meine das eher konzeptionell - und über Ausnahmen wie einen Absturz hab ich mir gar keine Gedanken gemacht, das ist mir einfach nicht passiert." Einem Computer, der mich bei diesem Ablauf unterstützt - vielleicht über ein Workflow Management System in einem Büro - müsste ich das natürlich anders mitteilen, vielleicht so: "Zwei Aktivitäten werden als parallel betrachtet, wenn sich deren Ausführungszeitraum zu mindestens 95% überschneidet. Bei Fehlern breche ab."

Worauf ich natürlich auch noch hinweisen will: Diese Zusammenfassung ist ebenso ein Modell, das von den Transkripten genau das herausgreift, was mir wichtig erscheint, um die grundlegenden Zusammenhänge verstehen zu können - und da ich als Informatiker oft etwas staunend vor der Philosophie stehe, ist es ohne Weiteres möglich, dass ich dabei auch wichtige Dinge über- oder anders gesehen habe, die vielleicht auch bei der Prüfung verlangt werden.

Daher ist es ohne Frage sinnvoll, sich die Audiomitschnitte zu den Vorlesungen herunterzuladen und anzuhören, wenn ihr euch wirklich mit dem Thema beschäftigen wollt.

Stoffzusammenfassung

Einheit I - Lippenbart und Remixing

| Vorlesung | MP3 | Transkript | |

| 03.10.08 | Teil 1 Teil 2 | Andreas Kirchner | herunterladen |

- Schlagwörter - Remixing, Bart, Zitat, Nachlass Wittgensteins und Nietzsches, Lev Manovich, Assembling, YouTube, Open Source Modell, Was ist Open Source

Lev Manovich. Quelle: http://www.uweb.ucsb.edu/~stevenwolfson/manovich.jpg

Lev Manovich. Quelle: http://www.uweb.ucsb.edu/~stevenwolfson/manovich.jpg Ted Nelson. Quelle: http://www.w3.org/2004/Talks/w3c10-HowItAllStarted/tednelson.jpg

Ted Nelson. Quelle: http://www.w3.org/2004/Talks/w3c10-HowItAllStarted/tednelson.jpg - Wie ist der Zusammenhang zwischen Open Source Software und Philosophie?

"Strukturphilosophie" (Einordnung in einen klassischen Bereich der Philosophie) vs. "Sushi-Philosophie" (Zielgruppenorientierung mit leicht "schleißigem" Touch): OSP soll eine neuartige Betrachtungsweise für ein neuartiges Phänomen sein - pragmatisch an der Zielgruppe jener Leute orientiert, die sich für Open Source interessieren - Welche Anknüpfungspunkte zur traditionellen Philosophie gibt es?

- Rechts- und Sozialphilosophie (geistiges Eigentum etc.)

- Geschichte und Theorie des Eigentums (marxistisch-sozialistische Theorien)

- Griechische Philosophie - antike gesellschaftspolitische vs. heutige technisch-gesellschaftliche Entwicklungen in der Informatik: damals konnte die Philosophie einen Beitrag zur Demokratisierung leisten (Radikaldemokratie) - Philosophie kann daher auch entscheidend viel mit dem "basisdemokratischen" Open Source zu tun haben.

- Die Betrachtung des Phänomens Open Source kann daher den Blick auf die Philosophie selbst verändern

- Welche Botschaft soll Remixing vermitteln?

Remixing funktioniert über Zitate: Man nimmt einen bekannten Fixpunkt her, dessen Bedeutung bisher klar schien (z.B. das Gemälde der Mona Lisa) und fügt neue Elemente dazu (z.B. einen Oberlippenbart im Salvador-Dalí-Stil), sodass etwas Neues entsteht (kulturelle Intervention).

Lev Manovich (Who is the Author? Sampling / Remixing / Open Source): Remixing in der DJ-Szene ab den 1970ern - basierend auf der digitalen Verarbeitung treten neue Formen der Kreativität auf, bspw. das Mischen von unterschiedlichen Tonspuren, die auch wieder auseinander genommen werden können.

Strukturell sind die Nachlässe von Wittgenstein und Nietzsche nach dem Remix-Prinzip aufgebaut. - Was ist Assembling?

"Zusammenstoppeln" von Inhalten wie etwa bei YouTube verändert die Aussage und Aussagekraft von Inhalten, stellt neue Bedeutungen und Assoziationen her - hier kommt die Möglichkeit zur politischen Intervention mit enormer Reichweite ins Spiel

Verschiedene Formen der politischen Beteiligung:

- Live-Veranstaltungen (Protestplakate etc.) - klassisch

- Aufzeichnung der Veranstaltung durch Medientechnologie (Foto, TV) - modern

- Remixes von vorhandenem Material (relativ risikolos, da man nicht so leicht abgeführt werden kann) - vollkommen neuartig durch Plattformen wie YouTube

- Was ist das Open Source Modell?

Ted Nelson - perfekt bugfreie Verweisungsstruktur bei Büchern, bevor es Hyperlinks gab; Links als Remix-Form, die vom User interaktiv und individuell zusammengestellt wird. - Was ist Open Source?

Das gesamte Geschäftsmodell der Softwareindustrie, allen voran das von Microsoft, basierte bis vor kurzem auf der (Ab-) Geschlossenheit und Nicht-Verfügbarkeit des Quellcodes (= jene Dateien, die die Programmbefehle in einer bestimmten Programmiersprache enthalten).

Man bezahlte also für ein (mehr oder weniger) fertiges Endprodukt, das man selbst nicht verändern konnte.

Alternative: Offener, garantiert stets frei verfügbarer Quellcode - erstmals in einem größeren Projekt verwirklicht bei Linus Torvalds' freiem Betriebssystem Linux mit der GNU General Public License (GPL; GNU steht für GNU is not Unix - eine rekursive Definition) von Richard Stallman.

Die GPL erlaubt es, Software beliebig zu verändern, solange die neue Version auch frei zur Verfügung gestellt wird (es gibt keinen Ausweg aus der GPL) In der Philosophie ist das so nicht möglich - bspw. weil es keine objektiven Quelldateien gibt, die von allen Maschinen auf gleiche Art ausgeführt werden könnten; Philosophie spielt sich zu sehr im Kopf ab, um wirklich Open-Source-tauglich zu sein. - Kommentar: Wie sinnvoll ist ein offenes Betriebssystem für Laien?

Hier könnte man provokant anmerken, dass Microsoft mit seinem Monopol der Computernutzung hervorragende Dienste leistet. Man bedenke dazu beispielsweise folgende Punkte:- Kompatibilität - Um auf verschiedenen Betriebssystemen laufen zu können, müssen Programme meist angepasst werden (Ausnahme: bspw. Java-Applikationen - hier bezahlt man die Portierbarkeit aber mit vergleichsweise langen Lade- und schlechten Ausführungszeiten)

- Wartbarkeit - Es existiert eine große Menge an Wissen zu MS Windows

- Benutzerfreundlichkeit - Man versuche, einen neuen Grafiktreiber auf einem Linux-System zu installieren!

- Flexibilität und Austauschbarkeit von Rechnern und Schulungsaufwand für Mitarbeiter

Andererseits steht man gerade als etwas fortgeschrittener Anwender bei einem Windows-System vor einem interessanten Dualismus: Einerseits versucht Microsoft nämlich ganz gezielt, alles als "so einfach wie möglich" zu präsentieren, wie es ja beispielsweise die Werbung für Windows XP unmittelbar nach der Jahrtausendwende suggerierte. Solange man als Benutzer keine allzu hohen Anforderungen an das System stellt, und vom Brennen einer DVD bis zum Bearbeiten der Tags von MP3-Dateien "brav" die integrierten Tools verwendet, wird man damit auch einigermaßen klar kommen; interessant wird es in der Praxis aber oft dann, wenn man sich aus der Bevormundung von Windows befreien will und feststellt, dass doch nicht alles so einfach ist wie es scheint: Gerade wenn Registry-Schlüssel betroffen sind, ist es oft notwendig, an mehreren, meist schlecht dokumentierten Stellen schlicht zu experimentieren, um ein Problem zu lösen.

Windows ist - wie viele Produkte von Microsoft - also hier etwas gespalten: Der Durchschnittsuser hat das Gefühl, damit seinen Computer mehr oder weniger zu beherrschen, während der genervte - plakativ ausgedrückt - Profi das Betriebssystem samt Firma belächelt und den Eindruck gewinnt, Microsoft halte seine Benutzer für naiv.

Meiner Erfahrung nach eignen sich hingegen viele Open Source Produkte nicht für Einsteiger, während sie für den fortgeschrittenen Benutzer überaus mächtige und flexible Funktionalitäten bereitstellen, viel leichter individuell anpassbar und gleichzeitig sehr robust und stabil sind - als Beispiele könnte man hier LaTeX (vs. Microsoft Word) ebenso nennen wie Mozilla Firefox (vs. MS Internet Explorer), den Gnome Desktop für Linux (vs. Windows), simple Texteditoren wie JEdit oder Emacs (vs. Note- oder Wordpad), oder auch die beliebte Entwicklungsumgebung Eclipse (vs. MS Visual Studio).

Einheit II - Gelebte Open Source Philosophie

| Vorlesung | MP3 | Transkript | |

| 10.10.08 | Teil 1 Teil 2 | Andreas Kirchner | herunterladen |

- Schlagwörter - Freie und Open Source Software (FOSS), Lipstick on a Pig, US-Wahlkampf, Radikale Demokratie, Athenische Verfassungen, Qualitätseinbruch in der DJ-Szene, Freiheit und Autorität

- Was hat Wiki mit Open Source zu tun?

Die Erstellung von Transkripten - etwa für diese Vorlesung - und deren Veröffentlichung im Philo-Wiki hat einen gewissen Charakter des Open Source, wenn man das gesprochene Wort als ursprüngliche Quelle betrachtet. Um den Redefluss leichter lesbar zu machen, ist es zumeist notwendig, ihn bei der Verschriftlichung einer Überarbeitung zu unterziehen. (siehe dazu beispielsweise auch diese Diskussion zu den Transkripten). In einer kooperativen Wiki-Umgebung verändern sich die Bewertung und das Funktionieren von Kompetenzniveaus ebenso wie die Dynamik der Produktion: Durch die Diskussionen wird Wissen weitergegeben, und der Diskussionsverlauf ist nachlesbar (Anmerkung: Hier nähern sich die Kulturen von Informatik und Philosophie offenbar an.) - produktive Beiträge haben damit einen Effekt auf die gesamte Community, es entsteht ein Vernetzungseffekt. - Was ist der Unterschied zwischen Free Software und Open Source?

Richard Stallman. Quelle: http://commons.wikimedia.org/wiki/File:Fmlatribu_-_06_(by-sa).jpgHier gibt es zwei verschiedene Philosophien:

Richard Stallman. Quelle: http://commons.wikimedia.org/wiki/File:Fmlatribu_-_06_(by-sa).jpgHier gibt es zwei verschiedene Philosophien: Eric Raymond. Quelle: http://de.wikipedia.org/w/index.php?title=Datei:Esr.jpg

Eric Raymond. Quelle: http://de.wikipedia.org/w/index.php?title=Datei:Esr.jpg

- Richard Stallman / GNU/GPL, Free Software Foundation (FSF): Will maximale Freiheit für das Individuum ("To understand the concept, you should think of 'free' as in 'free speech', not as in 'free beer'"); stark prinzipienorientiert

- Eric Raymond / Open Source Software: pragmatische Kompromisse lassen Spielraum zwischen gratis und bezahlt

Die Frage ist nun, wo die gebotene Freiheit operativ wird - in der Praxis ist dies genau durch die neuen Kooperationsmöglichkeiten der Fall, die sich dadurch ergeben, dass die im Entwicklungsprozess verwendeten Wissens- und Softwarequellen dauerhaft frei verfügbar sind.

- Was soll die Sache mit dem Lippenstift im US-Wahlkampf?

Es liegen mehrere Videoclips vor. Zunächst stellt die republikanische Präsidentschaftskandidation Sarah Palin fest: der Unterschied zwischen ihr und einem Kampfhund sei der Lippenstift. Barack Obama zehn Tage später, bezogen auf John McCain: "You can put lipstick on a pig, it's still a pig." In einem Video der Republikaner werden diese beiden Szenen aneinander gereiht, ohne dass klar wird, dass Obama von McCain spricht. Damit wird seine Aussage so dargestellt, as würde er Sarah Palin als Schwein bezeichnen. Dieses Verfahren wird im Spot gleich zweimal angewandt: Eine weitere Aussage einer Journalistin, die sich über den Sexismus in den Werbekampagnen beschwert, wird so geschnitten, dass der ursprüngliche Bezug auf die Kampagne von Hillary Clinton verloren geht.

Im konkreten Beispiel wird gezielt de- und rekontextualisiert, mit der Begründung, dass "eigentlich ja ohnehin alles mit allem zusammenhängt";

Wir müssen uns folglich die Frage nach Gesetzmäßigkeiten, Regeln, Normen und Ethik im Bereich des Remixings stellen.

Diese Frage taucht ganz allgemein bei ent-hierarchisierter (Meinungs-) Produktion auf - und damit auch bei Open Source. Einerseits ist es möglich, alle Meinungen als gleichwertig zu betrachten - in der Praxis ist dies aber meistens nicht zielführend, sondern hier gewichten wir die Meinungen von Personen in Abhängigkeit von gewissen Faktoren: Beispielsweise erachten wir einen Installateur als geeignet, eine qualifizierte Meinung zu einem Wasserrohrbruch abzugeben (hier gewichten wir etwa nach dem Beruf bzw. einer Fertigkeit oder Fachexpertise - griechisch techné. Ein System aus solchen Fachexpertisen, in dem die Teilnehmer bereit sind, gegenseitig für die erhaltenen Leistungen etwas zu geben, stellt die Grundbedingung für eine funktionierende Marktwirtschaft dar. - Und wie hat nun die Athenische Demokratie funktioniert?

David Johnson: "Radikale Demokratie ist furchtbar ineffizient", da es keine dezidierten Experten in der Politik gibt, die durch ihre Autorität für Kontinuität und Verlässlichkeit sorgen könnten.

Wer soll nun also die Politik bestimmen? - Hier ist in der Praxis ein Abwägen nötig!

- Experten im Fach? - hier wird kein Wert auf Führungskompetenz oder eine einheitliche Linie gelegt

- Rhetorisch Begabte? - wie sieht es mit deren Fachkompetenz aus?

- "Manager"? - also Führungs- und Verwaltungsexperten?

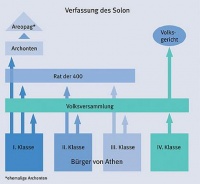

Nach der Verfassung des Solon wurden die 6.000 Mitglieder der Volksversammlung von den Bürgern gewählt, und diese bestimmten wiederum den Rat der 400. Im Gegensatz dazu sah die Verfassung des Kleisthenes vor, den Rat der 500, der Gesetze vorzuschlagen hatte, durch das Los zu bestimmen, was mit der Vorstellung vergleichbar ist, die Stadt Wien würde von 500 zufällig aus dem Telefonbuch gewählten Personen regiert.

- Was hat das mit der sinkenden Qualität in der DJ-Szene zu tun?

Die Autorität der Leute, die im Besitz der Produktionsmittel sind, wird unterwandert durch die Verfügbarkeit dieses Materials und damit die Möglichkeit zum Remix - es hat also praktisch jeder die Freiheit, auch ohne fachliche Kompetenz zum DJ zu werden, was die Qualität des Musik-Outputs insgesamt sinken lässt. Dies ist folglich eine Situation, in der ein Mehr an Freiheit eher einen Wildwuchs als eine Erhöhung des Qualitätsniveaus ergibt.

Einheit III - Geistiges Eigentum und Verkäuflichkeit

| Vorlesung | MP3 | Transkript | |

| 17.10.08 | Teil 1 Teil 2 | Helene Hagmann | herunterladen |

- Schlagwörter - Perikles, Demokratiedilemma, Sokrates, Platon, Sophisten, Peer Review, Elenchos-Methode, "Wir halten während der Analyse Dialog"

- Perikles volksnah - Träger der athenischen Demokratie

Das Staatsbürgerschaftsgesetz des Perikles sieht vor, dass nur jene Athener sein dürfen, die sowohl eine Mutter als auch einen Vater in Athen haben. Damit ist Staatsbürgerschaft erblich; Athen schottet seine bürgerlichen Freiheiten nach außen hin ab. - Das Demokratiedilemma

Es besteht ein Spannungsfeld zwischen unserer gedanklichen Tätigkeit und unserer wirtschaftlichen Aktivität - Fragen der Ethik und ökonomischer Verwertbarkeit von Wissen und Bildung treten auf, mit denen sich schon die alten Griechen beschäftigt haben:

Gegenüberstellung der Kommerz- und der Philosophiefraktion:

- Sophisten - bezahlte Wanderlehrer, die für sämtliche Auskünfte Geld verlangen

- Sokrates-Fraktion - sieht eine give-and-take-Situation von unbezahlten Gleichberechtigten im Gespräch; laut Sokrates ist es schändlich, etwa für Auskünfte über Politik Geld zu verlangen, da nur ohne Geld eine Kultur der Hilfsbereitschaft entstehen kann, die einen immateriellen und nicht-monetären Wert hat (gegen Bezahlung im Unterricht "in Sachen der Baukunst etwa", also bei der Vermittlung von Fachkompetenzen (technés), hat Sokrates hingegen nichts einzuwenden.)

Nach Sokrates entsteht automatisch ein Ungleichgewicht zwischen Wissendem und Unwissendem, da Letzterer von Antworten abhängig ist ("Es wird der Maßstab des Wissens angelegt"). Diese Situation kann man direkt mit Open Source Software in Verbindung bringen - hier müssen ebenfalls Gesetze herrschen, die nicht direkt von "Bezahlbarkeit" abhängig sind.

(Anmerkung: Ich würde Sourcecode weder als Bildung noch als Wissen betrachten, das gratis zur Verfügung gestellt wird (auch wenn man ohne Zweifel aus externem Code viel lernen kann) - vielmehr ist Quellcode imho ein Produkt aus operationalisiertem Wissen, das ganz klar an ein Designteam gebunden ist, denn hinter dem Code stehen zumindest eine Reihe von Modellen, die das erstellte System abbilden, und hinter diesen wiederum die Gedanken der Designer und Architekten, die diese niemals vollständig formalisieren (und somit nicht in Computersysteme bringen und wirklich objektiv austauschen) können. Dies erachte ich in der Praxis vor allem deshalb als wichtig, da Software zu einem guten Teil von Wartung und Weiterentwicklung "lebt" und für diese eine genaue Kenntnis der Systeme - zumindest auf der Design-Ebene von Modellen - sehr wichtig ist.).

Laut Sokrates ist Anerkennung unter Gleichberechtigten etwas "in sich Ruhendes".

- Elenchos - das sokratische Prüfverfahren

Wenn es bei einem Gespräch um mehr geht als um Unterhaltung, kommt der Qualität von Wissen eine Bedeutung zu - wie aber kann diese gemessen werden?

Sokrates - "Kreuzverhör" der Elenchos-Methode: Sokrates legt eine Form eitler Bescheidenheit an den Tag, indem er sich selbst "unwissend" stellt und seinem Gegenüber eine Reihe von Fragen, die alle zu bejahen sind. Sokrates nutzt den "Columbo-Effekt" und nimmt Ungereimtheiten und Verallgemeinerungen in den "gegnerischen" Argumenten als Ansatzpunkt für seine Fragen. Er führt sein Gegenüber nur durch diese Fragen zu einem Punkt, wo dieser seine eigene Position aufgibt und die sokratische übernimmt.

Das ist ihm deshalb möglich, da die meisten seiner Gesprächspartner nicht das Wesen der Dinge beschreiben, nach denen Sokrates fragt, sondern ihm konkrete Beispiele aus ihrem Fachbereich nennen, zu denen Sokrates aber Gegenbeispiele findet und seine Gegenüber so ratlos macht. Das ist das Wesen der Philosophie: Durch eine asoziale Störung des Allgemeinverständnisses tauchen neue Perspektiven auf - der Wert entsteht im Gespräch also durch die Tatsache, dass neue Fragen gestellt werden, und nicht durch die gegebenen Antworten. In einer Gruppe, die zu einem produktiven Ergebnis gelangen soll, ist diese Technik natürlich eine Behinderung.

(Anmerkung: das ist auch der Grund, warum sie in einer Disziplin wie der angewandten Informatik vergleichsweise selten einsetzbar ist - sie sollte imho daher auf den Bereich der Forschung und Philosophie beschränkt bleiben.)

Diese Technik bindet Sokrates in eine Gesprächssituation ein: "Wir halten während der Analyse Dialog" ([http://philo.at/wiki/index.php/Diskussion:Das_Demokratiedilemma_(OSP) Andreas Kirchner)

Man braucht für jedes Prüfverfahren Entscheidungsinstanzen; bei Elenchos "sind wir zugleich Richter und Sprecher" (Sokrates), also nehmen wir uns selbst die Autorität, durch unsere on-the-fly-Analyse die Wissensqualität zu bewerten. Sokrates legt sich hier natürlich eine Argumentation zurecht - er generiert durch Elenchos also Wissen auf eine dekonstruktive (nicht aber destruktive!) Art und Weise.

Hier könnte man fragen, was eigentlich passiert, wenn Sokrates einen zweiten Sokrates trifft - kann diese Form der "Wissenskooperation" überhaupt funktionieren? - Immerhin benötigt Sokrates für seine Technik genau diese elitäre Position in einer asymmetrischen Gesprächssituation! - Wissen kostet

Bildung als institutionalisierter Prozess verursacht zwangsläufig Kosten ("dieser Raum ist geheizt"); gleichzeitig hat die Wissenschaft, und allen voran die Philosophie, einen "reinen Wahrheitsanspruch", der von der monetären Dimension losgelöst sein will, sich aber in einer Bildungsinstitution mit ihr vermischt bzw. vermischen muss.

(Anmerkung - man könnte es auch so formulieren: Wissen ist zwar keine Ware im klassischen Sinne, aber seine Vermittlung benötigt Arbeit und diese gehört bezahlt, um den Wissenschaftsbetrieb am Leben zu erhalten.)

Wir können zwei Arten von Forschung unterscheiden:

- Angewandte Forschung - erzielt konkrete Ergebnisse, die ökonomisch ziemlich direkt verwertbar sind.

- Grundlagenforschung - generiert Wert auch ohne direkten Nutzen ("vom Nutzen der Nutzlosigkeit" - neue Perspektiven, langfristige Entwicklungen...)

Einheit IV - Redekunst und Fachwissen

| Vorlesung | MP3 | Transkript | |

| 24.10.08 | Teil 1 Teil 2 | Elisabeth Seidl | herunterladen |

- Schlagwörter - Platon, Marktplatz-Ideenhimmel-Dualismus, Sophisten, Redekunst, Gorgias, Fach- und Flachwissen, Laien, Expertentum, Laienrichter

- Welche Sonderstellung nimmt Plato in der Philosophie ein?

Plato ist mit Apple vergleichbar: So wie diverse neue Technologien - Internet, Audiokompression, RSS-Feeds, User-Centered-Design - beim IPod auf revolutionäre und richtungsweisende Art miteinander verbunden wurden, hat Plato für die damalige Zeit auf genauso revolutionäre und richtungsweisende Art die Besonderheiten des Wissens beschrieben: Anders als bei einer Speise, an der wir vor dem Verzehr riechen und so feststellen können, ob sie verdorben ist oder nicht, müssen wir Kenntnisse bzw. Wissen zuerst schlucken (also: uns aneignen), und sehen erst dann, dass sie uns - im schlimmsten Fall - verdorben haben.

Plato hat auch den bis heute bestehenden Dualismus in der Philosophie eingeführt:

- Das ökonomisch Auswertbare zur Organisation der Wirtschaft

- Das ökonomisch nicht direkt Verwertbare mit transzendentem Wert - die Präferenz der Philosophie und ein Vorschlag zur Organisation der Politik

Bis dato musste man sich praktisch auf eine der beiden Seiten schlagen; Open Source bricht diese strenge "Marktplatz-Ideenhimmel-Dualität" durch die Operationalisierung der freien Verfügbarkeit der Quellen aber auf.

- Gorgias und die Rolle der Redekunst

Hier ist es zuerst wichtig, einige Begriffe rund um das Wissen zu unterscheiden:

- Weltwissen lässt sich unterscheiden in Fachwissen (griechisch epistemé) und Flach- (oder Allgemein-) Wissen und ist relativ objektiv (oder zumindest intersubjektiv)

- Meinung (griechisch doxa) hat eine bewusste subjektive Komponente

Eine Anekdote zur Bedeutung von Rhetorik und Meinungsbeeinflussung: Die Kinder spielen und wollen ständig noch ein Stück Torte haben, der Arzt verbietet es ihnen aber, damit sie keinen Karies bekommen. Die Kinder aber halten Gericht und beschließen, die Ärzte - und nicht die Köche - aus der Stadt zu vertreiben, weil sie ihnen die Party runiniert haben. "In der platonischen Sichtweise ist Sokrates angeklagt worden von den Kindern als der Arzt - und gerichtet haben die Kinder".

Gorgias ist nun ein Sophist, der sich selbst als Experte für Meinungen, als Meinungsforscher und Meinungsmanipulator darstellt. Er behauptet von sich, zu allem etwas sagen zu können und tritt damit in den öffentlichen Bereich jenseits der Fachwissenschaften ein, in der auch die Philosophie agiert (das "Flachwissen"). Problematischerweise hat ein Rhetor aber genau in dem Moment seine Überzeugungskraft verspielt, sobald er zugibt, nur Meinungen beeinflussen zu wollen oder können, da er dann mangelnde Fachkompetenz offenbart. Damit gerät Gorgias wiederum in das Spannungsfeld zwischen den Sophisten und Sokrates, der die Frage stellt, welcher Maßstab denn im politischen Bereich gelten solle, um etwa Gerechtigkeit zu definieren und zu beurteilen. Hier gibt es erneut verschiedene Sichtweisen:

- Sokrates ist der Meinung, dass ein Peer Review durch Laienrichter in der Volksversammlung genauso funktionieren kann wie die Beurteilung der Qualität von Schuhen durch die Schustergilde - es existiert also unter den Laienrichtern kein Expertentum, sondern die Experten sind die Laienrichter selbst (vgl. auch Einheit III - bei der Elenchos-Methode sind die Sprecher zugleich die Richter, da sie vernetzt während der Analyse Dialog halten).

- Platon nutzt diesen freigespielten Raum dann, um eine Systematik für Sachkompetenz im nicht-ökonomischen ideellen Bereich zu definieren. Er definiert den Vernunftbegriff, und stellt fest, dass Leute aus verschiedenen Fachrichtungen, die Begriffe unterschiedlich verstehen, trotzdem vernünftig miteinander reden können, da sie als Menschen vernunftbegabte Wesen sind. Sein epochales Werk "Der Staat", das selbigen als Institution zur Erziehung seiner Bürger beschreibt, zeigt jedoch Platons antidemokratische Gesinnung.

- Gorgias und die Sophisten hingegen wollen die Qualität von politischen Reden nicht nach ihrem Sachgehalt, sondern nach ihrem Effekt beurteilen, womit das Durchsetzungsvermögen und die rhetorischen Künste zum Handwerkszeug der Politik werden.

Der Zusammenhang mit Open Source besteht nun erneut darin, dass hier durch das Internet die Möglichkeit besteht, die sokratische Analyse durch die ständige Vernetzung in einen beinahe kostenfreien Entwicklungs- und Erkenntnisprozess zu verwandeln, in denen Beiträge gemeinsam abgestimmt, korrigiert und weiterentwickelt werden können. Hätte das Internet damals schon existiert, hätte sich die Philosophie grundlegend anders entwickelt.

- Der große Sprung - Von der Antike zur Jahrtausendwende

Die antisophistische Haltung des Platon wurde im 4./5. Jahrhundert vom Christentum übernommen (der göttliche Platon), seine Ideenlehre als Dualismus zwischen hiesiger Welt und himmlischem Jenseits umgedeutet. In der Renaissance - also der Zeit der Wiederbesinnung auf die klassischen griechischen Schriften - gab es in Süditalien, ähnlich wie damals in Athen, Städte, die sich selbst verwalteten. Auch heute finden wir noch Spuren der sophistischen Ideen (Beispiel der Donau-Universität Krems, die kostenpflichtige Aikido-Kurse zur Konfliktbewältigung anbietet, was insofern mit den Sophisten zu tun hat, als diese ebenfalls ihr Wissen von auswärts nach Athen brachten.)

Einheit V - Überleitung zur Gegenwart

| Vorlesung | MP3 | Transkript | |

| 31.10.08 | Teil 1 Teil 2 | Sabine Klinger | herunterladen |

- Schlagwörter - Robert Cowan, Staatselefanten, Privatisierung, soziales Kapital, the Linear Model, Nutzen des Nutzlosen, Handwerk

- Über universitäre Bildung

Die Universität ist Teil des gesellschaftlich allgemein anerkannten Bildungssystems, dessen Abschlüsse mit einer Reihe von "sozialen Gütesiegeln" den Absolventen einen gewissen sozialen Status verleihen. Gleichzeitig existiert ein extra-universitäres, pragmatisch orientiertes Bildungsangebot, das meist kostenpflichtig ist und versucht, die Universitäten sozusagen "über die Überholspur zu übertrumpfen". - Bildung als öffentliches Gut

Öffentliches Gut ist eine Bezeichnung aus der Volkswirtschaftlehre - öffentliche Güter zeichnen sich durch Nichtausschließbarkeit und Nichtrivalität aus, das heißt, es ist einerseits nicht wirtschaftlich effizient oder möglich, einzelne Konsumenten von der Nutzung auszuschließen, und andererseits kann das Gut von mehreren Konsumenten verwendet werden, ohne dass diese sich gegenseitig behindern. Streng genommen sind damit weder das Eisenbahn-, noch das Postsystem zu den öffentlichen Gütern zu zählen, da hier über Fahrscheine oder die Frankierung Ausschließbarkeit herrscht. Eisenbahn und Post zählen daher zu den kollektiven Gütern oder Klubgütern.

Öffentliche Güter sollten nicht nach marktwirtschaftlichen Gesichtspunkten organisiert werden, da sie nicht im klassischen Sinne vom Wettbewerb profitieren können. Stattdessen bildet sich eine fragmentierte Basisinfrastruktur, die nur dort erhalten wird, wo mit einer hohen Wahrscheinlichkeit ausreichende Gewinne erwirtschaftet werden können. Dies ist aus zwei Gründen unerwünscht:

- Im Sinne der staatsbürgerschaftlichen Gleichbehandlung ist es unmoralisch.

- Eine schlecht ausgebaute Basisinfrastruktur verhindert die weitere Entwicklung im betroffenen Gebiet; daher rechnet sich die Privatisierung öffentlicher Güter auch wirtschaftlich nicht.

Marktwirtschaft lässt sich jedoch nicht nur in der monetären Dimension begreifen - als Kauf- bzw. Konsummotivation kann etwa auch der mit dem Gut erworbene soziale Status dienen; es gibt also auch einen sozialen Wert (man kauft sich Schuhe für eine Jobbewerbung - vgl. Subsistenzgüter, auf die keine Einkommenseffekte wirken, das heißt, sie werden mit gleicher Häufigkeit weiter gekauft, auch wenn sich das Einkommen des Konsumenten ändert - das können z.B. Lebensmittel wie Brot sein, die zum Überleben unbedingt nötig sind). Als soziales Kapital werden Wissenszusammenhänge und (teilweise auch unbewusste) Assoziationen bezeichnet, die unsere Einschätzungen, Einstellungen und Kenntnisse über den Wert von Gütern formen und dabei nicht nur den Preis berücksichtigen (bspw. gemeinschaftsbildende Funktion eines Obama-T-Shirts, da der Träger von Obama-Fans als gleichgesinnt ~ "wertvoll" ~ sympathisch eingeschätzt wird).

- Robert Cowan - "The University is No More"

Cowan ist Wissenssoziologe - er stellt fest, dass sich die "Staatselefanten"- also nationale Prestigeträger wie Fluglinien oder Universitäten - derzeit in einer Krise befinden und zunehmend privatisiert werden, wodurch ein Internationalismus mit durchaus fragwürdigen Bewertungsmechanismen entsteht - "Polemisch gesagt ist das Universityranking so genial wie eine weltweite Einschätzung aller Fußballklubs." Die Internationalisierung bringt jedoch auch Vorteile, wie etwa die Erleichterung für universitäre Austauschprogramme. Das "lineare Modell" des nationalen Innovationssystems aus Grundlagenforschung, angewandter Forschung und Produktion, das den Universitäten schlicht die Aufgabe der Grundlagenforschung zuordnet (Cowan ironisch: "the bad old theory"), funktioniert auf nationaler Basis ebenso nicht mehr - stattdessen agieren die Universitäten heute international vernetzt und werden zunehmend von ökonomischen Aspekten abhängig.

Anmerkung: In der Vorlesung werden hier Effizienz und (Schein-) Steuerbarkeit über Kriterien - also Kennzahlen - genannt. Interessanterweise sind genau diese drei Begriffe in der Wirtschaftsinformatik äußerst zentral, da sich IT-Systeme hervorragend eignen, um Kennzahlen automatisiert zu generieren und auszuwerten und - eine entsprechende IT-Systemarchitektur und -Organisation vorausgesetzt - auch relativ leicht über Kennzahlen steuerbar sind. Dabei stellen sich für mich zwei Fragen:

- Welche Kennzahlen werden gemessen? Was ist auf ökonomischer, was auf ethischer Ebene an Transparenz vertretbar, wenn man auf alle Betroffene (Stakeholder, nicht zu verwechseln mit den Shareholdern = Aktionäre) Rücksicht nimmt?

- Welche Konsequenzen werden aus den Messergebnissen gezogen?

Imho sind Kennzahlen in dieser Angelegenheit das primäre Werkzeug bzw. der Enabler schlechthin, um dem Wunsch nach Steuerbarkeit und Transparenz nachzukommen, jedoch kein Übel an sich, da sie nicht zwangsweise der Kostenminimierung zu Lasten der Qualität oder Arbeitssituation dienen. Schließlich müsste sich auch ein Kennzahlensystem entwerfen lassen, das den "Wert" modelliert, den ein Staat auf Kultur legt oder das auf den Drang nach Reflexion und Wahrheitsfindung Bezug nimmt. Es steht jedoch außer Frage, dass dies weniger als in der Vergangenheit gewünscht sein dürfte.

Als weiteren Punkt möchte ich anmerken, dass für mich gerade in der Vernetzung von Bildungsinstitutionen eine riesige Chance erkennbar wird, nämlich die Operationalisierung des Netzwerkgedankens auf institutioneller Ebene, der auf das Internet als Kommunikationsinfrastruktur und auf das WWW bzw. Web Services als Teil einer Dienstleistungsinfrastruktur zurückgreifen kann (wobei das Duo Internet/WWW die Möglichkeiten zum Wissensaustausch bereits revolutioniert hat).

Schaffen es Unternehmen und Universitäten, so ihre Forschungsprozesse effizient intern und extern zu vernetzen, müsste imho deren Gesamtleistung stark ansteigen. (Rein evolutionär betrachtet scheint Vernetzung überaus erfolgreich zu sein - so kann man unser Gehirn als stark parallelisierten und vernetzten Assoziationsagenten betrachten, der aus Neuronalen Netzen besteht; unsere Gesellschaft wiederum vernetzt unsere Gehirne durch Informations- und Kommunikationsstrategien und seit anderthalb Jahrhunderten auch durch entsprechende Technik, was uns Zugriff auf bisher nie dagewesene Wissensmengen beschert.

Durch den ersten Vernetzungsprozess - der Ausbildung des höchst entwickelten irdischen Gehirns, das gleichzeitig die komplexeste Struktur des bekannten Universums ist - hat der Mensch alle anderen Lebewesen der Erde geistig übertroffen, während die gesellschaftliche Vernetzung in den letzten Jahrtausenden einen Fortschritt vom Beginn des Ackerbaus bis hin zur heutigen Überflussgesellschaft hervorgebracht hat.)

- Ottfried Höffe - "Vom Nutzen des Nutzlosen"

Laut Höffe diffamiert der Begriff des "Nutzlosen", der die Geisteswissenschaften in unserer neoliberal geprägten Gesellschaft in den defensiven Rechtfertigungszwang bringt, eine sehr nützliche Dimension, die...- kulturelle Offenheit und Toleranz fördert;

- Personen offensteht, die sich dem Zwang zur Erwerbsarbeit entziehen;

- für Dinge wie Gerechtigkeit, Moral, Literatur, Musik, bildende Kunst, Architektur und eigenständig-kritisches Denken sensibilisiert (und somit meiner Meinung nach einen wesentlichen Beitrag dazu leistet, dass deren Studenten mündige Bürger werden oder bleiben).

Frei ist also, wer sein Leben nicht auf den Tausch funktionaler Beziehungen beschränkt, sondern es um seiner selbst willen führt. Bildung ist der einzige Weg, um zu verhindern, dass Flachwissen zur Herrschaft des Pöbels wird. Die Philosophie steht hierbei in einer übergeordneten Metarolle, da sie den Weg zur Bildung dadurch ebnet, dass sie das eigenständige und kritische Denken fördert. Die Frage ist nun, wie die Philosophie mit dieser Metarolle umgehen soll (vgl. Wittgenstein, Heidegger) - hier entstehen im Bereich des Open Source völlig neue Ansätze des kooperativen Umgangs mit Wissen: Das Flachwissen als Kollaboration zwischen global verteilten Wissensträgern zu sehen ermöglicht es der Philosophie, ihre Metarolle überhaupt aufzugeben - diese würde ja von der global vernetzten Kollaboration übernommen, die somit zum Bildungsfundament erhoben wäre (Anmerkung: und dazu auch entsprechend gut verankert sein müsste!).

Open Source ist vor allem deshalb so attraktiv, da es das Vorhandensein von gesellschaftlichen Wirkungsfaktoren veranschaulicht, die nicht den (neoliberalen) Marktmechanismen unterliegen.

- Philosophie, Linux und die Open Source Bewegung

Richard Sennett - "The Craftsman": Handwerkerinnen sind dadurch motiviert, dass sie eine Materialverbundenheit an den Tag legen, was auch bei Open Source Projekten so gesehen werden kann, wobei hier immaterielle Handwerksgüter produziert und gehandelt werden.

Einheit VI - Handwerksgeschichte, GNU und Linux

| Vorlesung | MP3 | Transkript | |

| 14.11.08 | Teil 1 Teil 2 | Doris Wertgarner | herunterladen |

- Schlagwörter - Pekka Himanen, Gebäudetypen, Netzakademie, Geschichte von Unix, Space Travel, Ken Thompson, C, Intel 386, GNU C Compiler, GNU Public License / Freiheiten, Richard Stallman, Microsoft, MS-DOS, Bill Gates, Minix, GNU Linux, Free Software vs. Open Source

- Pekka Himanen - The Hacker Ethic and the Spirit of the Information Age

Himanen sieht ebenfalls eine Verbindung zwischen Platon und den Gedanken des Open Source Modelle (Hrachovec: Himanen macht jedoch absolut nichts aus dieser Feststellung). In der Szene tritt häufig die Assoziation von Gebäudetypen mit Organisationsformen der Softwareentwicklung auf:- Pekka Himanen - "The Academy and the Monastery", wobei das Kloster als Beispiel für eine stark hierarchisch organisierte Produktionswerkstatt dienen soll, ist eine Anspielung auf eine richtungsweisende Arbeit von

- Eric Raymond - "The Cathedral and the Bazaar"

Ein für Open Source typisches Kooperationsmodell bezeichnet Himanen als Netzakademie: Lernende geben ihr soeben erarbeitetes Wissen in einer selbst geschaffenen Umgebung weiter (Anmerkung: Das lässt sich direkt mit Sokrates' Idee des Dialogs während der Analyse verbinden und es geht in die Richtung des "zugleich Sprecher und Richter Seins").

- Die Geschichte von Unix

Laut einer Anekdote hat Ken Thompson Unix 1969 deshalb entwickelt, weil er ein Betriebssystem brauchte, um das Science-Fiction-Spiel Space Travel auf einem (damals als "Mini" bezeichneten) Computer spielen zu können, nachdem seine Firma Bell Laboratories aus dem entsprechenden Projekt ausgestiegen war. Er benötigte also zwei grundlegende Dinge, ohne die kein Computer sinnvoll programmiert werden kann: Unix-Pioniere Ken Thompson (links) und Dennis Ritchie. Quelle: http://de.wikipedia.org/w/index.php?title=Datei:Ken_n_dennis.jpg

Unix-Pioniere Ken Thompson (links) und Dennis Ritchie. Quelle: http://de.wikipedia.org/w/index.php?title=Datei:Ken_n_dennis.jpg- Eine Programmiersprache - eine Reihe von Befehlen, die alle von der Hardware unterstützten Operationen kapselt; diese Sprache nannte er "C".

- Eine logische Systemorganisation - also eine Menge an Softwarekomponenten, die alle Teile des Systems sinnvoll ansprechbar macht, gesammelt in einem (Betriebs-) Systemkern bzw. Kernel; Unix steht für Uniplexed Information and Computing Service.

Bell stellte sowohl Unix als auch C frei zur Verfügung, da man keinen wirklich Einsatz für die Produkte hatte - Unix verbreitete sich darauf rapide in den damaligen Großrechenzentren und wurde somit auch das Betriebssystem des Arpanet, des militärischen Vorläuferprojekts zum Internet; die Internetprotokollfamilie TCP/IP wurde erstmals auf Unix-Rechnern implementiert und nach wie vor läuft ein Großteil der Rechner im Backbone (in der Telekommunikation bezeichnet das Wort "Backbone" einen verbindenden Kernbereich eines Telekommunikationsnetzes mit sehr hohen Bandbreiten) des Internet auf Unix-Derivaten. AT&T wurde 1975 jedoch auf Unix aufmerksam und meldete Eigentumsansprüche an - worauf eine Gruppe von Designern zwei Jahre später die letzte freie Unix-Version in ein Projekt names Berkeley Software Distribution (BSD) aufnahm, das nach wie vor existiert.Andrew S. Tanenbaum. Quelle: http://de.wikipedia.org/w/index.php?title=Datei:AndrewTanenbaum.JPG1985 schließlich veröffentlichte Richard Stallman das GNU Manifest und gründete die Free Software Foundation (FSF). Im gleichen Jahr stellte Intel den Prozessor mit der Nummer 386 vor, der es durch seinen Protected Mode erstmals ermöglichte, in einem Personalcomputersystem ein Timesharing Multiusersystem auszuführen, da Systemaufgaben in einem eigenen Bereich des Chips getrennt von den Benutzerinputs liefen. Durch diese Abschottung des geschützten Modus entstand zusätzliche Freiheit, da "mehrere Benutzer gleichzeitig alles machen können". (Timesharing bedeutet in diesem Zusammenhang, dass der Prozessor mehrere Programme - die auch von unterschiedlichen Benutzern gestartet werden können - pseudo-parallel laufen lässt, indem er jedes Programm nur einige Millisekunden lang ausführt und dann durch "context switching" zum nächsten Programm übergeht; die Programme teilen sich also die Prozessorzeit.) Linus Torvalds. Quelle: http://de.wikipedia.org/wiki/Datei:Linus_Torvalds.jpeg

Linus Torvalds. Quelle: http://de.wikipedia.org/wiki/Datei:Linus_Torvalds.jpeg

Richard Stallman hat nicht nur das GNU Manifest geschrieben, sondern mit dem GNU C Compiler (GCC) auch den nach wie vor effizientesten Compiler für die Sprachen C und C++ veröffentlicht, der am Markt verfügbar ist (ein Compiler übersetzt Quellcode, der in einer bestimmten Sprache geschrieben ist, in eine andere Sprache - er transformiert also Code durch die Anwendung grammatikalischer Regeln; im konkreten Fall C-Code in Maschinensprache.) Stallman wollte zusätzlich ein freies Betriebssystem entwickeln, das er aber nicht fertig brachte - an diese Stelle trat etwas später Linus Torvalds' Linux.

Die meisten PCs liefen zu dieser Zeit auf dem Betriebssystem von Microsoft, MS-DOS - einem Unix-Derivat, bei dem Bill Gates einen entscheidend genialen ökonomischen Schachzug gemacht hatte: Er behielt sich das Recht vor, MS-DOS auf allen nicht-IBM-Rechnern verwenden zu dürfen und kassierte dafür Lizenzgebühren. Durch die viel billigere Herstellung von beinahe identischen Rechnern in Asien, die ebenfalls mit MS-DOS betrieben wurden, sank weltweit der Preis für PCs dramatisch und der Aufstieg von Microsoft begann.

1991 begann Linus Torvalds, das von Andrew S. Tanenbaum für seine Studenten geschriebene "Spielsystem" Minix zu einem vollwertigen freien Betriebssystem für Intels 386-Chip weiterzuentwickeln und so Stallmans Werk zu vollenden. Natürlich waren für dieses Betriebssystem weitere Programme nötig, um wirkliche Aufgaben (Textverarbeitung, Mailversand...) erledigen zu können, weshalb alle von der FSF entwickelten Unix-Tools zum Linux-Kern gepackt, als Linux-Distributionen (meist frei) vertrieben und fortan mit GNU Linux bezeichnet wurden.

- Welche Freiheiten sind in der GNU Public License (GPL) definiert?

Hier gibt es vier Grundfreiheiten, die Stallman - in der Tradition der Informatik - mit 0 beginnend nummeriert: Freie...

- 0. Nutzung für jeden Zweck

- 1. Verfügbarkeit des Quellcodes und Anpassung

- 2. Weitergabe "so you can help your neighbor"

- 3. Verbesserung des Programms, Veröffentlichung unter den gleichen freien Bedingungen, unter denen das Programm bezogen wurde.

Punkt 3 stellt somit die Kontinuität der freien Verfügbarkeit sicher und verhindert die Privatisierung und damit den kostenpflichtigen Vertrieb des Programms.

- 0. Nutzung für jeden Zweck

- Über Freiheit, Free Software und Open Source

Richard Stallman wird nachgesagt, eine Obsession in Bezug auf "Freiheit" zu haben; Open Source - mit dessen Hauptvertreter Eric Raymond - setzt an die Stelle der Freiheit hingegen "nur" die freie Verfügbarkeit des Quellcodes, was Stallmans Unwillen vor allem deshalb erregt hat, da das Wort "offen" nichts mit "geistiger Freiheit" zu tun habe. Stallman selbst weist jedoch darauf hin, dass kommerzielle freie Software kein Widerspruch, sondern die kommerzielle Entwicklung, Verbreitung und Verwendung freier Software durchaus wichtig sei. In der Tat ist GNU Linux keinesfalls frei von kommerziellen Einflüssen: So sah IBM das GNU-Linux-Projekt als "Geschenk des Himmels" gegen Microsoft und investierte Milliarden in die Entwicklung freier Software, um sie auf seinen Maschinen laufen lassen zu können.

Einheit VII - OSP praktisch

| Vorlesung | MP3 | Transkript | |

| 21.11.08 | Teil 1 Teil 2 | Amin Hassan | herunterladen |

- Schlagwörter - Wissensextraktion, Wisdom of the Masses, Raymond's Trilogy, Entwicklungsmodelle: Hierarchisch, Kathedrale / Emacs, Kunsthandwerk / \TeX , Verteilt-kooperativ / Fetchmail

- Cass Sunstein - The Wisdom of the Masses

US-amerikanischer Rechtsanwalt und Autor, der in seinem Buch "Infotopia" feststellt, dass große Menschenmengen in bestimmten Situationen Information und Wissen besser produzieren und verarbeiten als Einzelpersonen, selbst wenn die Einzelpersonen im betroffenen Gebiet Experten sind. Daraus ergibt sich die Frage, unter welchen Umständen dieses Phänomen auftritt und wie sich das in der Bevölkerung verteilte Wissen optimal extrahieren und nutzen lässt. Antworten dazu sind im Design von Fragebögen bei Umfragen ebenso zu finden wie in der Domäne der Gruppenpsychologie. Sunstein fragt im Hintergrund, ob die neuen Technologien des Web 2.0 hier eine Hilfe sind. (Anmerkung: Technisch gesehen steckt in Web 2.0 kaum etwas, das nicht auch schon vor zehn Jahren existiert hat (konkret: ein klassisches Webserversystem, das auf eine Skriptsprache wie PHP zurückgreift, wird meistens mit clientseitigem Code wie JavaScript oder Java Applets kombiniert, um Dynamik in den sonst statischen HTML-Seiten und asynchrone HTTP-Aufrufe zu ermöglichen, um den Benutzungskomfort und damit die Attraktivität zu erhöhen.); revolutionär an Wikipedia, Flickr, Facebook und Co. ist jedoch die Idee der verteilten, kooperativen Bearbeitung und oft auch deren Einbindung in betriebliche Funktionszusammenhänge (wie es etwa geschieht, wenn man bei Amazon.com eine Video-Rezension zu einem Produkt hochlädt)). - Das an dieser Stelle begonnene Interludium rund um Sokrates habe ich in die Zusammenfassung zu Einheit III verschoben, wo es um Sokrates geht.

- Warum stellt Open Source die Philosophie in Frage?

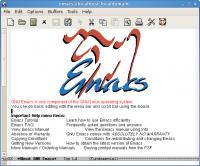

Screenshot von Emacs. Quelle: http://www.gnu.org/software/emacs/tour/images/splash.png

Screenshot von Emacs. Quelle: http://www.gnu.org/software/emacs/tour/images/splash.png Donald Ervin Knuth. Quelle: http://www.stanfordalumni.org/news/magazine/2006/mayjun/images/features/knuth_don.jpg

Donald Ervin Knuth. Quelle: http://www.stanfordalumni.org/news/magazine/2006/mayjun/images/features/knuth_don.jpg

Die sokratische Asymmetrie der unangenehmen Fragen, die auch der heutigen Philosophie noch inhärent ist, tritt bei der Entwicklung von Linux nicht mehr auf; hier ermöglichte die freie Verfügbarkeit des Quellcodes eine Arbeit ohne Prinzipienbruch unter Gleichberechtigten.

Anmerkung: Das können wir aber nur behaupten, wenn wir entweder...- nur den Entwicklungsprozess betrachten, die Anwender und deren Nutzungsverhalten von Linux aber ausklammern, oder...

- die Anwender nicht als Kunden betrachten (denn ansonsten haben wir ja wieder einen Prinzipienbruch, wenn auch nicht unbedingt einen sokratischen: der Entwickler ist wissend und elitär, während der Anwender durch seine mangelnde Kompetenz - selbst wenn er den Quellcode ansehen oder sogar ansatzweise verstehen kann - unterlegen ist), sondern in den Entwicklungsprozess einbinden, wie es Eric Raymond vorschlägt.

- Eric Raymond's "Trilogy"

Es gibt drei einigermaßen wegweisende Artikel des Open-Source-Pragmatikers:

- The Cathedral and the Bazaar - herkömmliche versus Entwicklung im Open-Source-Bereich (am Beispiel des Linux-Kernels)

- Homesteading the Noosphere - behandelt Eigentumstabus

- The Magic Cauldron

- Entwicklungsmodelle im Bereich der Free und Open Source Software

- Emacs und die Kathedrale - der hierarchische Entwicklungsstil

Die "Kathedrale" - der aufgrund seiner flexiblen Programmierbarkeit und Leistungsfähigkeit im Unix-Bereich richtungsweisende Texteditor Emacs - wurde von "Dombaumeister" Richard Stallman entwickelt. Hier trat eine sogenannte Fork auf, also eine Spaltung in der Entwicklung, die durch Richtungsdifferenzen zwischen Stallman und einigen anderen Mitgliedern der Community bedingt war, was aber durch die freie Kultur und die Offenheit des Quellcodes kein Problem darstellte, aber in der FOSS-Szene trotzdem selten vorkommt und äußerst begründungs- und entschuldigungsbedürftig ist. In diesem Entwicklungsstil entsteht Autorität hauptsächlich durch Kompetenz. - TeX und das Kunsthandwerk - der eigenverantwortliche Entwicklungsstil

Der IT-Guru Donald Knuth hat über Jahrzehnte hinweg praktisch im Alleingang ein Schriftsatzprogramm entwickelt, das höchsten Ansprüchen an Qualität, Internationalisierung und Automatisierung genügt - TeX (gesprochen "Tech"). - Fetchmail und die verteilte Kooperation - der Internet-Entwicklungsstil

Fetchmail von Eric Raymond ermöglicht es in einer Unix-Umgebung, Mails, die an ein zentrales Rechenzentrum gesandt wurden, automatisch auf lokale Rechner zu kopieren und übernimmt dabei die nötige Adressierung. Ein solches Programm ist deutlich weniger komplex als TeX oder Emacs, aber Raymond geht es darum, auf bereits vorhandenes Wissen über das Internet zuzugreifen und dieses in einem verteilten Kooperationsprozess in der Entwicklung zu nutzen. Dazu ist frei verfügbarer Quellcode der externen Programme ebenso notwendig wie ein gewisser Unternehmergeist. Ganz zentral ist aber eine gut ausgebaute Infrastruktur im Internet, was laut Eric Raymond der Hauptgrund war, dass Unix noch nicht so entwickelt wurde ("the internet was not yet good enough").

Eric Raymond operationalisiert den Vernetzungsgedanken also ganz massiv und meint, dass auch die Benutzer von Software in den Entwicklungsprozess einzubinden sind, um Code schnell verbessern und effektiv debuggen zu können.

(Anmerkung: Dieses "treating your users as co-developers" (Raymond) ist in der traditionellen kommerziellen Softwareindustrie verpönt, da der Benutzer oft für ein nur scheinbar fertiges Produkt zahlt und sich dann als Beta-Tester missbraucht fühlt.)

Während Richard Stallman nach der sozialen Nützlichkeit fragt und Software nicht kostenpflichtig machen will, weil dies die Kreativität der Gemeinschaft einschränken würde, sieht Raymond diesen Sachverhalt aus einer nüchtern-pragmatischen Perspektive - nämlich: die Qualität steigt, wenn Gemeinschaften statt Einzelpersonen denken -, aus der sich aber trotzdem Features von Ethik und Eigentumslosigkeit ergeben.

- Emacs und die Kathedrale - der hierarchische Entwicklungsstil

Einheit VIII - Das theoretische Potenzial

| Vorlesung | MP3 | Transkript | |

| 05.12.08 | Teil 1 Teil 2 | Martina Dobner | herunterladen |

- Schlagwörter - Knorr / Deutungsoffenheit, Umdeutung, Kel Ewey / Sonnenbrillen, User Innovation, User Feedback, Tragedy of the Commons

- Literatur zum theoretischen Potenzial

Drei Beiträge sind im Kontext der Vorlesung relevant:

- Alexander Knorr - Die Deutungsoffenheit der Quellen,

- Stephen Weber - The Political Economy of Open Source und

- André Gorz - Wissen, Wert und Kapital.

- Alexander Knorr - Die Deutungsoffenheit der Quellen

Knorr präsentiert eine ethnologische Perspektive: Jedes Artefakt (= ein künstlich hergestelltes Ding) manifestiert zugleich Lebensweisen; Software ist aber in dieser Beziehung ein eigenartiges geistiges Konstrukt, dessen Produktion keinesfalls mit der Erstveröffentlichung beendet ist (Anmerkung: das gilt umso mehr für Freie und Open Source Software, die beständig kooperativ weiterentwickelt wird).

Wenn wir nun noch die Unterscheidung zwischen Artefakt und Produkt betrachten, so wird klar, dass gerade freie Software keine klare Trennung zwischen Produzenten und Konsumenten aufweist und der Produktbegriff, wie wir ihn in unserer kapitalistischen Gesellschaft zu verwenden gewohnt sind, an sich nicht treffend ist, sondern den "Nutzen- und Gebrauchsdingcharakter auf eine komplett überraschende Art und Weise neu aufrollt". Anders gesagt: Wir können die offenen Quellen ohne Weiteres umdeuten, wie das Volk der Kel Ewey im folgenden Beispiel:

Im Wüstenvolk der Kel Ewey tragen die Männer häufig Sonnenbrillen, was in Anbetracht ihres Lebensraums auf den ersten Blick auch durchaus logisch erscheint. In der Tat dienen die Sonnenbrillen aber nicht zum Schutz vor der Sonne, sondern sie perfektionieren die traditionelle Verschleierung des Mannes - sie wurden also in einem kultur- und gesellschaftsspezifischen Kontext umgedeutet.

Software, die nicht frei ist, kann man nun den Charakter von Sonnenbrillen zuschreiben, die man nur aufsetzen darf, wenn die Sonne scheint; sie ist also nicht deutungsoffen und kann daher auch nicht umgedeutet werden.

Anmerkung: Das erscheint mir konzeptuell äußerst unlogisch; Angenommen, unsere Sonnenbrille heißt Microsoft Excel, und wir schreiben mit diesem Programm die Stoffzusammenfassung für eine Vorlesung, dann geht das ohne Zweifel am Sinn von Excel als Tabellenkalkulation vorbei. Wenn wir das als Umdeutung sehen, ist jede Software, die wir in anderer Funktion als eigentlich vorgesehen verwenden, deutungsoffen; wir müssen sie also nicht umprogrammieren, um sie umzudeuten, genausowenig wie die Kel Ewey die Sonnenbrillen technisch verändern - hier kommt es ebenfalls nur auf den Einsatzzweck an!

Nach Knorr sei es ein Fehlschluss zu glauben, der von Ingenieuren eingeschriebene Sinn einer Maschine sei dominant; Maschinen, die problemlos demontiert und wieder zusammengebaut werden können, könnten jedoch genauso leicht modifiziert und so umgedeutet werden, was zu einer Auflösung der Asymmetrie zwischen Produzent und Benutzer führe.

Anmerkung: Für Computerhardware würde ich durchaus der Tatsache zustimmen, dass es hier Probleme beim Basteln gibt, sobald man mehr machen will, als einige Bausteine neu zu kombinieren, da mit herkömmlichen Mitteln an Transistoren im Nanometerbereich nicht zu basteln ist oder wir eine Festplatte nicht zerlegen können, ohne sie zu zerstören. Ich finde es aber wiederum fraglich, inwieweit dieses Beispiel auf Software übertragbar ist. - User Innovation und Kapitalismus

Die Betriebswirtschaft erkennt zunehmend den Wert, den das Wissen des Kunden für das Unternehmen besitzt, und fragt hin und wieder bei den Kunden nach Verbesserungsvorschlägen und ihrer Zufriedenheit mit den in Anspruch genommenen Diensten. Allerdings kommt es in dieser Situation oft vor, dass der Kunde seinen eigenen Vorteil, den er durch eine ehrliche Rückmeldung erzielen könnte, als zu gering sieht, um zur Zusammenarbeit wirklich motiviert zu sein. Andererseits muss dem Kunden ebenfalls unterstellt werden, ein gewisses Eigeninteresse zu verfolgen, das sich etwa darin manifestieren könnte, dass er mit der Art, wie seine Rückmeldungen verwertet werden könnten, nicht einverstanden ist und daher nicht kooperiert.

Wie Yochai Benkler - ein New Yorker Jurist und Soziologe - in seinem Artikel "Coase's Penguin" expliziert, gelten unter den Bedingungen der offenen Kooperation über Netzwerke die von Coase genannten Konstanten der Motivation teilweise nicht mehr, unter anderem da der Einfluss des Individuums auf die Produktionssituation viel höher ist. Coase hatte untersucht, unter welchen Bedingungen sich Firmen in einer kapitalistischen Marktwirtschaft bilden und für seine Forschungen den Nobelpreis erhalten. - The Tragedy of the Commons - die Allmendeproblematik und neue Wirtschaftsmodelle im Internet

Dieses klassische Beispiel aus der Volkswirtschaftslehre zeigt anhand einer gemeinsam genutzten Dorfwiese (Allmende) das Problem, das bei Gütern vorliegt, bei denen gleichzeitig Nichtausschließbarkeit und Rivalität herrschen: Kurz gesagt schickt eine Person plötzlich doppelt so viele Kühe auf die Allmende und diese fressen den anderen das Gras weg, sodass ein immer größeres Ungleichgewicht entsteht.

Das gleiche Problem beschreibt Gosh in "Cooking Pot Markets" am Beispiel eines großen gemeinsamen Kochtopfes, für dessen Befüllung alle Gäste Zutaten mitbringen und bei dem die Koordination der Teilnehmer nötig ist, um überhaupt etwas Essbares zu produzieren. Hier gibt es einerseits das Allmendeproblem und andererseits können unerkannt free rider - Trittbrettfahrer - zum Essen erscheinen, die zwar vom Topfinhalt mitessen, aber selbst nichts mitgebracht haben.

Durch das inhärente Wesen geistiger Produktionen liegt bei freier Software eine etwas andere Situation vor, nämlich die der verlustfreien Vervielfältigungsmöglichkeit, die es nicht gestattet, jemandem etwas wegzunehmen (es können also beliebig viele Kühe auf dieser Dorfweide fressen). Im Internet ändern sich die Wirtschaftsverhältnisse neuerlich, etwa was den Bereich der Werbung betrifft: So lebt Google von der Selbstidentifikation seiner Benutzer über die verwendeten Suchbegriffe; öffentlichkeitswirksame Werbekampagnen sind damit völlig überflüssig.

Als Motivation, für die Benutzer kostenlose Webforen zu bestimmten Themen aufzubauen - ein Prozess, in den Zeit und Geld zu investieren ist - kann beispielsweise der Anreiz dienen, dass durch den gemeinschaftlichen Austausch zu diesen Themen Wert entsteht, der nicht direkt materiell oder monetär messbar ist, wie etwa Anerkennung. - Stephen Weber - "The Political Economy of Open Source Software" und User Driven Innovation

Laut Weber ist user driven innovation von seinen Konzepten her so generisch, dass dieser Ansatz auch außerhalb der Softwarebranche einsetzbar ist. User driven Innovation setzt zwei Bedingungen voraus:

- Kooperatives Verhalten und

- die wirtschaftliche Logik nicht-rivalisierender Güter.

Die klassische Ökonomie basiert auf der Annahme, dass ohne Knappheit keine Wirtschaft möglich ist, da man für Güter, die in beliebigen Mengen verfügbar sind, kein Geld verlangen kann. Dies steht aber offensichtlich im Widerspruch zur wirtschaftlichen Verwertbarkeit von Wissensproduktionen, wo - wie im Falle der Entwicklung von freier Software - positive Netzwerkeffekte auftreten; es entsteht also umso mehr Wert, je mehr Personen das Wissen besitzen, was einen klar anti-rivalisierenden Effekt darstellt und nicht mit dem Gedanken der Knappheit vereinbar ist.

Netzwerkeffekte können jedoch auch negativ sein, wenn sie mit bestehenden Eigentumsordnungen in Konflikt geraten, wie der "Overkill" am Musikmarkt zeigt, der unter anderem durch eine beinahe unbeschränkte Verfügbarkeit von MP3s bedingt ist.

Einheit IX - Wissensökonomie und Wachstumstheorie

| Vorlesung | MP3 | Transkript | |

| Vorlesung 19.12.08 | Teil 1 Teil 2 | anonymous | herunterladen |

- Schlagwörter - Klassische Ökonomie, Adam Smith, Paul Romer, Wachtsumstheorie, Funktionen des Preises, Ideenverknappung durch Patente, André Gorz, Ökonux

- Warum Ökonomie?

Nachdem sich die bisherigen Betrachtungen hauptsächlich der Theorie gewidmet haben, stellt die wirtschaftliche Verwertbarkeit einen konkreten "Reality Check" dar, wie sich Umsetzungen dieses theoretischen Potenzials in der Praxis bewähren. - Adam Smith - die klassische Ökonomie

Nach dem klassischen Modell der Wirtschaftswissenschaften, das Adam Smith im 18. Jahrhundert aufstellte, entsteht zusätzlicher Wert in der Produktion durch die Kombination aus folgenden Faktoren:- Land,

- Arbeitskraft,

- Kapital, das durch Investoren wie den Geldadel aufgetrieben wird und

- die zentrale Idee, dass durch die Segmentierung gewisser Arbeitsschritte ein höherer Gesamtoutput zu erzielen ist.

Dieser zusätzliche Wert wird von den Kapitalisten abgeschöpft. In seiner grundlegenden Struktur befinden sich auch heutige Produktionsbetriebe noch in diesen Wirtschaftszusammenhängen - so ist es nach wie vor üblich, Unternehmen anhand ihres materiellen Vermögens und ihrer Schulden zu bewerten.

Microsoft - oder, noch deutlicher: Google - lassen sich in diese Logik jedoch nicht ohne Weiteres eingliedern, da ihre Geschäftsmodelle auf Ideen basieren, deren Produkte - sobald sie einmal erzeugt wurden, wie das Betriebssystem Windows oder die Suchmaschinen- und Werbearchitektur von Google - sich ohne größeren materiellen Aufwand verbreiten lassen. Diese Firmen beziehen ihren Wert folglich aus geistigen Kapazitäten, was ein deutliches Zeichen dafür ist, dass wir in einer postindustriellen ("Wissens-") Gesellschaft leben.

- Paul Romer und die Neue Wachstumstheorie

Paul Romer. Quelle: http://edge.org/documents/edge08/images800/paul_04G5978%20small.jpg

Paul Romer. Quelle: http://edge.org/documents/edge08/images800/paul_04G5978%20small.jpg

Der amerikanische Wirtschaftswissenschafter Romer stellt fest, dass dem Preis im klassischen Wirtschaftsmodell zwei grundlegende Funktionen zukommen:

- Er hilft dem Produzenten, Produktionsentscheidungen zu treffen und

- Er teilt die erzeugten Güter den Konsumenten zu (Anmerkung: und zwar genau jenen, die bereit sind, den höchsten Preis zu bezahlen, was im Sinne der Volkswirtschaftslehre der Inbegriff von Effizienz ist, aber ethische Kriterien nicht berücksichtigt.)

Dieses Modell basiert jedoch auf der Grundannahme der Knappheit aller Wirtschaftsgüter, die es im Ideenbereich nicht gibt. Somit stellt sich die Frage, wie man die Produktion von Ideen motivieren kann, wenn die Produzenten wirtschaftlich denkende Wesen sind und ihre Ideen gewinnbringend verwerten wollen, da es hier einen Konflikt gibt:

- Die Ideenproduzenten werden motiviert, mehr Ideen zu produzieren, wenn sie dafür mehr Geld erhalten.

- Ideen sind ihrer Natur nach nicht-rivalisierend - sie können also von beliebig vielen Konsumenten ohne gegenseitige Behinderung genutzt werden - und ohne dass durch die Verbreitung relevante Kosten entstehen.

- Ideen sind ihrer Natur nach nicht-ausschließbar.

- Ideen sind folglich nicht knapp - sobald jemand die Idee verstanden hat, kann er sie nutzen, wofür der ursprüngliche Produzent der Idee aber nichts bekommt.

- Denkt der Ideenproduzent also wirtschaftlich rational, ist er nicht motiviert, Ideen zu produzieren - der Ideenmarkt versagt, bricht zusammen und es gibt gar keine Ideen mehr.

Die Wirtschaftswissenschaften sehen zur Lösung dieses Problems die Möglichkeit vor, dem Ideenproduzenten über Patente für eine beschränkte Dauer ein exklusives Nutzungs- und Verwertungsrecht für die Produkte zuzusprechen, die seiner Idee entstammen. - Wird der Ideenproduzent aber geschützt, so wird er seine Produkte zu einem Preis anbieten, die seine Forschungskosten zumindest decken.

- Oft sind die Forschungskosten aber sehr hoch und viele Konsumenten daher nicht mehr bereit oder in der Lage, den für die Produkte geforderten hohen Preis zu bezahlen - der Markt versagt erneut, wie es etwa bei AIDS-Medikamenten in Afrika geschieht.

- Um dem Marktversagen vorzubeugen, entsteht ein Preiskompromiss (Romer: "unhappy compromise"), der für beide Seiten nicht wirklich zufrieden stellend ist; In dieser Situation erfüllt der Preis seine zweifache Regulierungsfunktion folglich nicht mehr.

Ein weiterer Lösungsansatz, der auch die Asymmetrie zwischen Forschungskosten und Ertragsmöglichkeiten berücksichtigt, ist die Förderung der Ideenproduktion - durch Fonds wie beim Health Impact Fund oder durch direkte staatliche Subventionen.

Um eine Ideenproduktion in einem gemeinschaftlichen Umfeld überhaupt erst zu ermöglichen, ist eine entsprechende Kommunikationsinfrastruktur bereitzustellen, die Austausch und Koordination ermöglicht, ohne hohe Transaktionskosten anfallen zu lassen, wie es im Kontext von freier Softwareentwicklung durch das Internet und die Dienste des WWW - beispielsweise durch Voice-over-IP-Dienste, E-Mail und Code-Repositories mit Versionsverwaltung - verwirklicht ist.

- Paul Romer über Ausschließbarkeit und Patente

Die Nichtrivalität von Ideen sei inhärent, aber die Ausschließbarkeit - etwa über Patente - wird laut Paul Romer erst in sozialen Kontexten geschaffen, um durch diese künstliche Verknappung aus der Idee ein Wirtschaftsgut machen zu können.

Selbstverständlich sind dieser Verknappung Grenzen gesetzt - so ist etwa die Idee, in einem Onlineshop Vorschläge zu machen, welche Produkte ähnlich zu denen sind, für die sich der Kunde gerade interessiert, ohne Frage viel Geld wert, da sie die Umsätze beträchtlich steigern kann; allerdings erschiene es absurd, diese Idee des One-Click-Shops zu patentieren.

Nach Romers Theorie entsteht Wachstum heute daraus, dass eine Person ihren Kopf statt ihrer Muskeln einsetzt und Ideen produziert, die sich wirtschaftlich verwerten und in immer fortschrittlichere Produkte umsetzen lassen. - André Gorz und die linke Schiene der Ökonomie

In seinem Werk "Wissen, Wert und Kapital. Zur Kritik der Wissensökonomie" (2004) kommt Gorz zu ähnlichen Schlüssen wie Romer - er verbindet diese jedoch mit der marxistischen Theorie und folgert, dass genau die Prozesse, die den Menschen im Lauf der Industrialisierung durch die Arbeitsteilung entfremdet haben, durch die Produktionssituation in einer Wissensgesellschaft rückgängig gemacht werden können. Er belegt dies anhand von Beispielen aus der neuen Betriebsplanungs- und Personalentwicklungslehre, die auf Motivation und Zufriedenheit durch die Identifikation der Mitarbeiter mit ihrem Betrieb und ihrer Arbeit setzt, um die Gesamtproduktivität zu steigern.

(Anmerkung: André Gorz wird deshalb auch mit dem Begriff des "Wissenskommunismus" in Verbindung gebracht.) - Open Source Ökonomie praktisch - Ökonux

Ökonux = Ökonomie + Linux; diese linke Theoriegruppe zieht die Konsequenzen aus der Open Source Bewegung im marxistischen Kontext und versucht, deren Ideen für eine fortschrittliche Ökonomie weiterzuentwickeln.

Einheit X - Wissensökonomie und Eigentum

| Vorlesung | MP3 | Transkript | |

| Vorlesung 09.01.09 | Teil 1 Teil 2 | Andreas Hubmer | herunterladen |

- Schlagwörter - Grenznutzen, Diminishing und Increasing Returns, Monopole und Patente, Schutz geistigen Eigentums, Intellectual Property Rights, Prinzip der Vollkommenheit, Open Science

- Gorz, Stallman und die Ökonomie

André Gorz besitzt eine inhaltliche Nähe zu Richard Stallman - auch wenn Letzterer die individuelle Freiheit anstatt des gesellschaftlichen Nutzens in den Vordergrund stellt und sich somit als Libertarier präsentiert, sehen und fördern beide einen revolutionären Umsturz bestehender Wirtschaftszusammenhänge. - Vom Grenznutzen oder Die revolutionäre Ökonomie der Wissensgüter

Das klassische bzw. neoklassische Wirtschaftsmodell unterscheidet sich in einem Punkt grundlegend von der Ökonomie, die im Bereich von Wissensgütern und damit auch in jenem von Software anzuwenden ist - dem Grenznutzen. Dieser Begriff aus den Wirtschaftswissenschaften bezeichnet jenen - üblicherweise monetär ausgedrückten - Nutzen, den eine einzelne zusätzlich hergestellte Einheit eines Guts bringt (genauso spricht man von Grenzkosten, wobei gilt: Grenznutzen - Grenzkosten = Grenzertrag (marginal return); mathematisch sprechen wir hier von der ersten Ableitung der Kosten- und Nutzenfunktionen).

- Klassische Güter - Abnehmender Grenznutzen (diminishing returns)} bedeutet, dass die Erträge umso geringer werden, umso mehr produziert wird bzw. produziert werden soll; als Beispiele wären hier etwa die mit größeren Produktionsmengen immer teurere Ölförderung oder die Überdüngung eines Ackers zu nennen, die den Boden vergiften kann. In der Mathematik werden konvexe Kurven herangezogen, um diesen Zusammenhang zu modellieren.

- Wissensgüter - Zunehmender Grenznutzen (increasing returns) hingegen tritt dann auf, wenn der Nutzen umso größer wird, je mehr produziert und abgesetzt werden kann, etwa weil Netzwerkeffekte auftreten (wie beim Telefon) und die Kopierkosten sehr gering sind (wie bei Wissensgütern und vor allem bei Software).