Diskussion:Datenschwemme (BD2015)

ad: Chris Anderson:

Im Text von Chris Anderson wird erklärt, dass die schiere Menge der Daten einen anderen Zugang zur Datenverarbeitung verlangt, da in Bezug auf Big Data klar geworden ist, dass die Datenmengen nicht mehr zu einem umfassenden Ganzen zusammengefasst werden können, das in seiner Gänze überschaubar wäre. Eine Folgerung wird rasch vorgenommen: “It forces us to view data mathematically first and establish a context for it later.” Wenn man die Datenflut nicht überblicken kann, ist es also das Beste, einfach weiter Daten zu sammeln, denn irgednwann wird sich schon von selbst etwas daraus ergeben. Denn die Daten sprechen für sich selbst.

Der Ausgangsthese ist meiner Meinung nach zuzustimmen; die Datenmengen werden unüberschaubar. Allerdings wäre eine alternative Folgerung naheliegender: Je mer Daten gesammelt werden, desto unüberschaubarer wird das Ganze. Und das betrifft die Input- ebenso wie die Prozess- und die Output-Phase.

Mit “Input” sind diejenigen gemeint, die die Daten generieren: Menschen und Artefakte, die in welcher Weise auch immer tätig sind. Je mehr Daten erhoben werden, desto schwieriger wird es für den Datenproduzenten zu überblicken, wie und auf welche Weise Daten gesammelt werden. Das macht die Regelung dieser Vorgänge schwierig. Je mehr Datenerhebung vorgenommen wird, desto komplizierter werden die Regelungen, die diese Erhebung betreffen und die garantieren, dass der einzelne Betroffene damit konform geht oder gut in den Erhebungsprozess eingebunden ist. Je mehr Datenerhebung, desto mehr “privacy agreemetns”. Nun ist, man nehme etwa Walter Lippmann und seine Argumentation in The Phantom Public; es sei nicht möglich, dass jeder zu jeder Zeit alles weiß. Es ist zu viel verlangt, wenn vorausgesetzt wird, dass sich User über die hinzuaddierten Überinkünfte ausreichend im Klaren sind. Je mehr Faktoren daran beteiligt sind, desto unübersichtlicher und zeitintensiver wird es, einen Überblick zu behalten, welche Daten wie erhoben werden und was damit passiert. Dass in dem Text von Chris Anderson davon nicht die Rede war, erzeugt den Eindruck, als werde die Meinung vertreten, Daten seien einfach da. Dass dies nicht der Fall ist, weil Daten erst erzeugt werden müssen, ist der erste Hinweis, dass die Daten nicht für sich selbst sprechen; sie werden durch ihre Erzeuger formuliert. In welcher Weise diese Formgebung stattfindet ist eine Frage, die noch vor der Bearbetiung entschieden werden muss, oder die zumindest im Zuge des Bearbeitungsprozess immer wieder neu gestellt werden muss. -> Erster Einwand: Die Frage, was das für Daten sind und auf welche Weise sie erhoben werden, geht der mathematisch-statistischen Bearbeitung voraus. Je unüberschaubarer die Datenmengen, desto unüberschaubarer die Art der Regelungen, wie diese Daten erhoben werden. Der Kontext bedingt die Erhebung.

Mit “Prozess” ist die Verarbeitung der Daten gemeint. Im Text von Anderson wird darauf hingewiesen, dass Daten etwas tun; sie sprechen für sich selbst, woraus sich Aussagen über die Wirklichkeit der Welt ergeben. Ob Daten nun von Wissenschaftlern oder von “unbemannten” Computerprogrammen prozessiert werden, es handelt sich bei dem Prozess der Verarbeitung um eine Prozess der Übersetzung. Wenn Interessen und Vorlieben von Menschen oder zurückgelegte Wegstrecken, die vom Mobiltelefon erkannt werden, geschieht eine Übertragung einer Form oder gar eines Identitätskonstrukts; aus Literaturgeschmack und Muskelbewegungen werden mathematisch erfassbare Aussagen, diese werden zu elektrischen Impulsen, die über Kabelverbindungen um die Welt rasen, daraus wieder datenbankmäßig erfassbare Aussagen und daraus hierarchisch geordnete Suchergebnisse. Alle diese Erscheinungsformen haben nichts miteinander gemeinsam, außer den Weg, den sie zurücklegen, also die Spur der Übersetzungen, Bewertung, hierarchischer Einordnung, usw., die sie absolviert haben. Nun mag man der Meinung sein, dass sich Daten, eben weil es sich vermeintlich um mathematisch-statistische Aussagen handelt, ohne “Kosten” übersetzt werden können, aber diese Perspektive ist nicht überzeugend. Eine Rücküberetzung nach dem Transport bleibt immer noch eine Übersetzung; Reduktion ist kein Zurückgehen zum Ausgangspunkt, sondern nur eine weitere Art von Transport. Und die Art des Transprots ist ganz erheblich dafür verantwortlich, was am Ende herauskommt. Die Unübersichtlichkeit der Datenmengen betrifft also nicht nur die User, sondern auch diejenigen, die mit der Verarbeitung der Daten zu tun haben, seien es nun menschliche oder nicht-menschliche Verarbeiter. -> Zweiter Einwand: Die Zunahme der Quantität der Daten ergibt keine Ordnung, ganz im Gegenteil: Je mehr Daten, desto mehr Übersetzungen, desto weniger Übersicht.

Mit “Output” ist das Resultat gemeint, das sich durch den Prozess ergibt. In Andersons Text wurde das Wort “Modell” verwendet, das mit einer bestimmten Art von “Wahrheit” in Verbindung gebracht wird. Dass sich “Wahrheit” ergibt ist nicht anzunehmen, eher, dass sich Wahrheiten ergeben, die abhängig von der jeweiligen Form der Übertragungsleistung sind. Solche Wahreiten können höchstens Dispositive, in Foucaults Sinnn, sein. Daten sprechen nicht für sich selbst, sondern sie sprechen durch andere. Was sind diese Modelle wert, wenn abhängig vom Datenverarbeitungsprozess viele von ihnen entstehen? Korrelationen sind für sich genommen nicht genug, denn es muss mit entschieden werden, wie sie erzeugt wurden. -> Dritter Einwand: Korrelationen werden nicht eindeutig einordenbarer, wenn sie vermehrt werden. Je mehr Daten, desto mehr Möglichkeiten der Erzeugung von Korrelationen. Je mehr hinzuaddierte Möglichkeiten der Korrelation, desto weniger Übersciht ergibt sich.

Die Beschäftigung mit dem Phänomen der Big Data setzt die Annahme voraus, dass die Zunahme der Datenmengen eine Zunahme der Unübersichtlichkeit bedingt. Die Folgerung, es ergebe sich wie von Zauberhand Ordnung und Struktur, scheint überhastet und nicht schlüssig.

Was sich allerdings ergibt und meiner Meinung nach genauere Betrachtung verdient, ist die Möglichkeit, Kontroversen zu kartographieren. In dem Text Landscaping Climate Change von Rogers und Marres werden zwei Probleme von suchmaschinenbasierter Datenerhebung vorgestellt: “Moreover, it attempts to tackle the current inadequacy of Internet search engines, especially their inability to render source context and impart indications of the socio-epistemological value of information. (Rogers und Marres 1999 2) Die Vernachlässigung des Kontexts wurde bereits angedeutet: Daten werden erzeugt, ihre Prozessierung in Form von Übertragungen macht sie unübersichtlich, was eine Art Heuristik notwendig macht. “Whether or not the logics are intelligible to the user, ultimately he or she relies on his own personal framework of understanding to filter the flows anew.” (Rogers und Marres 1999 3) Die Unbestimmtheit des Ergebnisses, dessen “Wert”, ergibt sich nicht aus der zunehmenden Menge der Daten, sondern aus einer Bewertung heraus, die nicht von der Suchmaschine gewährleistet werden kann. Aus diesem Grund liegt es nahe, sich für Erziehung und Bildung der Nutzerinnen auszusprechen. Das ist allerdings ein anderes Thema. Was im bisher erörterten Zusammenhang interessant scheint, ist dass durch die Unübersichtlichkeit der Datenflut keine Einigung über den Kontext und über den “Wert” der daraus entstehenden Muster (Suchergebnisse) gibt. Das wurde auch von Anderson impliziert, als er davon sprach, dass sich diese Aspekte erst aus den Daten heraus ergeben müsse. Google ist hierbei aber nur ein Diskussionspartner in der Debatte darüber, wie die Kontexte und Werte konstruiert werden.

Mit “Diskussion” ist hier nicht “Diskurs” gemeint. Kontexte und Werte sind keineswegs nur im Bereich des Sozialen, Symbolischen, Meinungshaften zu finden. Die datenbankmäßige Verarbeitung der Big Data geht über das Vermögen des Menschen hinaus, hieß es bei Anderson. Kontroversen können auch innerhalb von Aussagen auftreten, auch innerhalb von Übersetzungsvorgängen, die nicht nur von Menschen vorgenommen werden, sondern auch von Computern und die “Diskussionen”, die sich ergeben, sind nicht nur auf menschliche, sondern auch auf nicht-menschliche Gesprächspartner angewiesen. Einen Beleg für die Vermenung von Menschen und Artefakten in Diskussionsprozessen liefert die von Rogers und Marres vorgestellte Studie betreffend den Klimawandel und die Diskussion darüber im Web. (Rogers und Marres 1999 6). An einer solchen Diskussion sind nicht nur Menschen beteiligt, sondern auch Kühe, Autos, Thermometer, usw. Und diese sprechen für sich selbst nur durch andere Beteiligte.

Die Artefakte spielen also eine Rolle. So weit kann man mit Anderson mitgehen. Allerdings wäre es ein Fehlschluss anzunhemen, dass, nur weil Dinge “verlässlicher” scheinen als Menschen, sich durch sie Muster und Strukturen in Form von Gesetzen zeigen würden, die mehr “Wahrheit” bieten, als bisher erzeugt worden ist. Es ergeben sich höchstens Regeln, die wesentlich kontingenter sind als Gesetze. Menschen wie Artefakte addieren durch ihr Tun beiderseits in die Zirkulation des Diskurses eingehende “Wahrheiten” und sofern alle Beteiligten, der Kontext und die Entscheidung über den Wert der Ergebnisse zusammengetragen sind, lässt sich auch etwas über die wirkliche Welt sagen, allerdings als Ausgangsbasis für Debatten und nicht in Form von Ordnung, die sich laut Anderson von selbst ergeben soll. Was Anderson übersieht, ist dass diese Ordnung durch Kontroversen angeregt wird, die mühevoll durchgearbeitet werden müssen, was mal mehr, mal weniger, aber doch immer Kosten verursacht; von einer “sich von selbst ergebenden” Ordnung keine Spur. Eine alternative Anwendung von Big Data schlagen Rogers und Marres vor:

“In the search by individuals and groups for potential common ground, alliance-building, consensus-formation, and new substantive positions, the discursive maps, queried for the relations of positions taken by debating parties, would show who’s taking which stand, in reference, for example, to one or more future scenarios currently under consideration.” (Rogers und Marres 19)

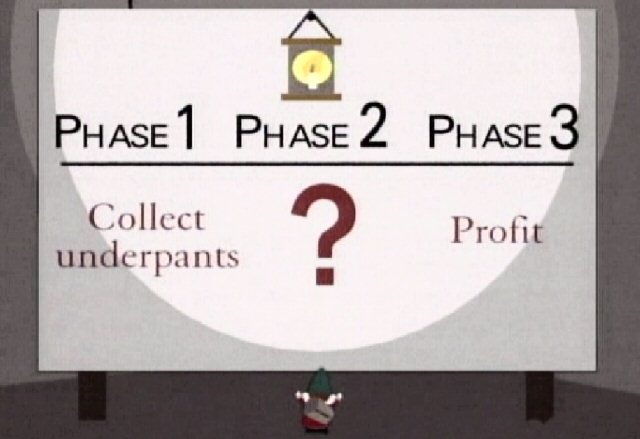

Ich kann mir eine kleine Polemik nicht verkneifen. Ich möchte Chris Anderson gegenüber nicht respektlos wirken, aber der von ihm vorgeschlagene Plan erinnert doch zu sehr an den Plan der Unterhosenwichtel, die bei einer beliebten Animationsfernsehserie vorkommen:

Literatur:

Lippmann, Walter (2009) - The phantom public; Transaction Publ.; New Brunswick, NJ

Obar, Jonathan A. (2015) - Big Data and the Phantom Public: Walter Lippmann and the Fallacy of Data Privacy; working draft; http://papers.ssrn.com/sol3/papers.cfm?abstract_id=2239188

Rogers, Richard und Marres, Noortje (2000) - Landscaping climate change: a mapping technique for understanding science and technology debates on the World Wide Web; http://govcom.org/publications/full_list/ROGERS_Marres_pus.pdf

Euphon (Diskussion) 10:40, 30. Nov. 2015 (CET)